关于 AI 时代的硬件到底应该做成什么样?

AngryMiao 最早部署了章鱼,这是第一个训练了硬件 API 可以操作硬件的模型。之后发现 Qwen2.5 的替代方案,微调部署后 14G 内存。

再之后 Qwen 0.5, 2GB 内存,实测也可以理解人类语言,给出硬件控制代码。

功耗优化方面,限制模型的输出可能结果集可以有效的提升本地模型的续航能力。4600 毫安电池可以认为支持大概 2500 次调用。模型输出限定后,调用次数翻倍。

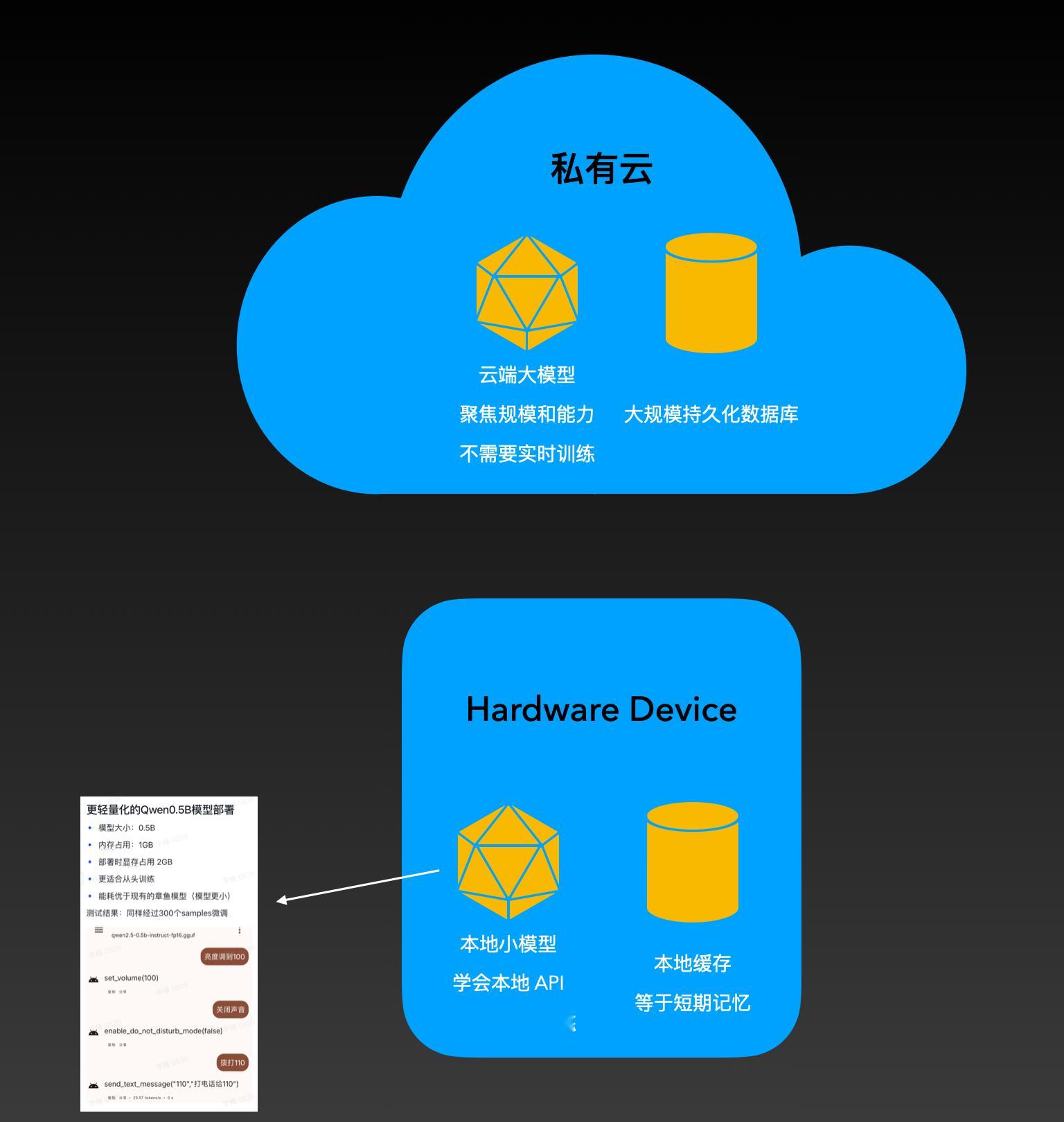

简单结论,未来本地模型,本地数据缓存,配合云端模型,持久化数据库应该是 ai device 的标配技术架构。

对于本地模型的要求就是小内存占用,低功耗。与此同时,因为模型足够小,在功耗优化乐观的情况下,实时学习/或者某种频率的自己微调,有机会成为可能。

而云端模型,应该就是通吃的,永远用最聪明的,用户又不差那点钱。不需要有实时学习能力(规模太大了也不现实),数据库应该是传统关系数据库配合 RAG 的概率高。

那么 AI Device 品牌,在云端应该尽量少干活。大规模模型的发展速度太快了,你根本追不上。确保知识 update 即可。被逼无奈,可以做点提示词工程,数据持久化的事情就好了。

而端侧小模型,基本的微调,提示词工程,内存和功耗优化是基本功。

而目前,这方面做的最好的,其实是理想汽车。[允悲]

手机厂家还在梦游。。。[汗]

更小的设备上,主要还是电力不行。。。但是传感器,则是一定要增加了。[鼓掌]