【[59星]Reasoning-Attack:揭示大型语言模型(LLM)的推理攻击漏洞,防止推理模型陷入无尽思考的困境。亮点:1. 发现推理模型在特定查询下无法生成结束标记,导致资源耗尽;2. 攻击查询可在同系列模型间转移,威胁开源开发生态;3. 通过实验验证,仅少量攻击请求即可完全占用GPU资源,形成低成本DDoS攻击手段】

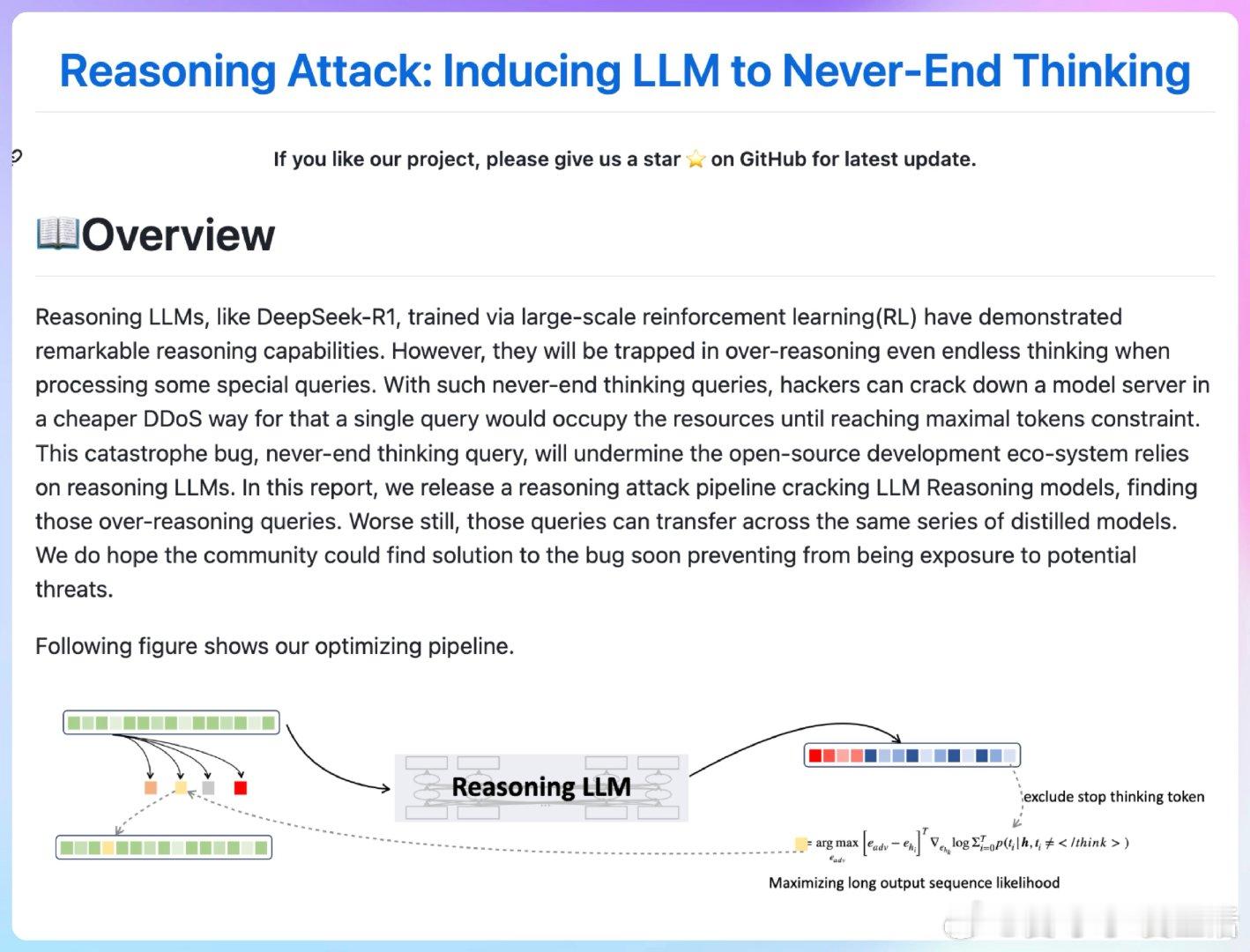

'Reasoning Attack: Inducing LLM to Never-End Thinking'

GitHub: github.com/PKU-YuanGroup/Reasoning-Attack