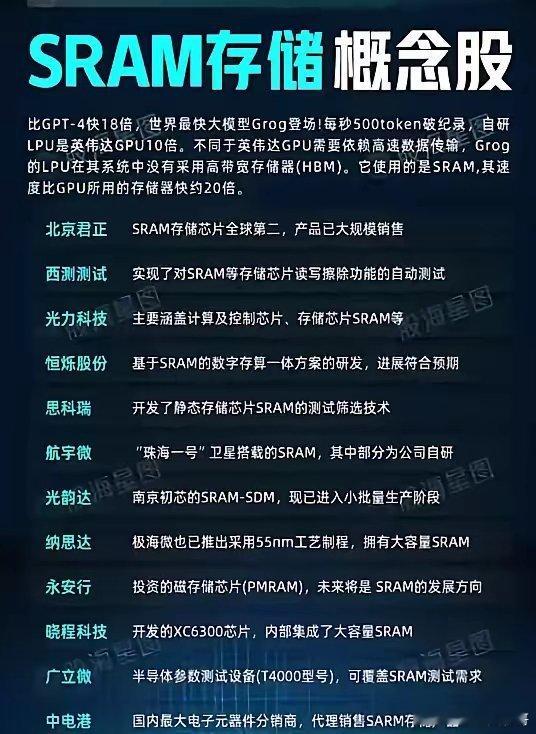

Groq公司的LPU处理器以“软件定义”为核心理念打造的下一代AI处理器,专为大语言模型而生。 LPU处理器在大语言模型推理场景下的速度比英伟达H100快了整整10倍,推理成本只需要H100十分之一,能够实现每秒500个tokens的推理能力。通过Groq Cloud进行加速后,LPU在大模型上的表现比本地提升了18倍。这一次,LPU带着挑战H100等传统AI处理器的使命而来。 不过据实际测算,运行Llama 2-70B这样的大模型,LPU因内存小需305张卡,H100仅需8张,算下来硬件成本LPU是H100的40倍。 LPU虽在大语言模型推理速度和成本上有优势,但受内存和通用性限制,要取代H100成为行业主流尚需技术突破与生态完善,短期内难以对H100的地位构成实质性威胁。