自1995年Cortes与Vapnik开创性地提出支持向量机以来,人工智能领域便迎来了技术革新的浪潮。从SVM的精准分隔到LSTM解决序列数据的长期依赖,再到语义网构想的提出,每一步都深刻影响着科技的走向。进入21世纪,随着深度学习的兴起与大数据的爆发,AI技术更是日新月异,从条件随机场到LDA主题模型,再到AlexNet在ImageNet的突破,人工智能正逐步揭开其神秘面纱,引领着新时代的科技革命。

今天是我们的第二章第4节第1篇:开门迎客:现实和虚拟的心灵交互

1995年,Cortes和Vapnik这两位连接主义领域的大师,提出了一种名为支持向量机(SVM)的算法。这个算法就像是在数据的海洋中寻找一块神奇的大陆,这块大陆能够将不同的数据岛屿清晰地分隔开来。

SVM的目标是在特征空间中找到一个超平面,这个超平面就像是一条界河,能够有效地区分开两类不同的数据点集。它的一个显著特点是它追求最大化两类数据点之间的间隔,这就像是在两个阵营之间划定一条最宽的无人地带,确保双方的士兵不会越界。

而且,这个间隔是数据点到分割超平面的最近距离,SVM算法寻找的超平面不仅要能够正确地分开训练数据中的点,而且要尽量使这个间隔最大化,这样做的目的是为了提高模型对新数据的预测能力,就像是建立一个坚固的防线,能够抵御未知的侵袭。

假设打铁老汉面前有一堆混在一起的铁器,他需要将它们分类。如果直接在桌面上操作,可能需要花费大量时间。但老汉如果能够像武侠小说中的高手一样,用御剑飞行的招数从高处俯瞰,就能更容易找到将铁器分开的最佳位置。SVM正是利用了这种思想。

SVM的强大之处在于能够通过核技巧处理非线性问题,并且通过最大化间隔提高模型的泛化能力。因此,SVM在图像识别、文本分类、生物信息学等领域得到了广泛的应用,就像是一把锋利的剑,能够精准地切割开数据的复杂性,揭示出其背后的真相。

1997年,连接主义再下一城,LSTM模型诞生。

LSTM的诞生是为了解决传统RNN(循环神经网络)在处理长时间序列数据时遇到的梯度消失或爆炸问题。而这些问题就像跑长途的老式火车由于燃料不足,导致无法到达目的地一样。

借助引入一套精巧的门控机制,相当于给火车头装上了高效能的涡轮增压器,使其能够有效地捕获序列数据中的时间依赖性,从而在长距离传输中保持强劲的动力。而这些门包括遗忘门、输入门和输出门。

举个例子,还是老汉打铁铸剑的场景,他需要根据剑的形状和热度来调整敲打的力度和位置,这就好比是LSTM网络处理信息的方式。此时,老汉的大脑就像是LSTM的细胞状态,记录了到目前为止的所有信息,并决定下一步应该如何行动。

火炉的热度就像是遗忘门,它告诉老汉哪些信息是重要的,需要保留,哪些信息是过时的,可以丢弃。而敲打的技巧则相当于输入门和输出门,输入门决定哪些新的信息应该被加入到他的技巧中,输出门则决定他应该如何使用这些技巧来塑造剑的形状。

有了LSTM,就能够记住过去的经验(细胞状态),根据当前的情况做出决策(通过门控机制),并不断调整自己的行动,以打造完美的剑(处理序列数据)。这样,LSTM就能学习和记忆长期依赖关系,在序列任务中做出智能决策。

LSTM不仅提高了RNN处理长期依赖问题的能力,也为后续的深度学习研究提供了新的方向和可能性,就像是在人工智能的铁匠铺中,打造出了一把能够开启未来大门的钥匙。

1998年,有互联网界“爱因斯坦”之称的蒂姆·伯纳斯·李,提出了一个让机器和人类无障碍沟通的大胆设想——语义网:若每个网页都能像人一样聪明,理解网页内容的含义和上下文,那么搜索引擎就能更精准地找到你想要的信息,而不是一堆关键词的堆砌。这与Web 3.0智能网络的理念不谋而合。

时间终于来到了21世纪,此时互联网和计算机技术已经趋于成熟,这让人工智能研究有了更可靠的依赖,人工智能领域也不负众望,每年都有很大的提升。

2001年,NLP领域的大佬John Lafferty带来了条件随机场(CRF),这就像是给计算机装上了一个翻译官,让它能够更好地理解语言的奥秘,比如在一句话中正确地识别人名和地名。同一年,布雷曼提出随机森林理论,将多个有差异的弱学习器(决策树)并行组合,通过群策群力做出最好决策。

2003年,David Blei提出了LDA主题模型,其能够揭示隐藏在大量文本之后的主题,能够告诉我们这些文字背后究竟在谈论什么。同一年,Google的三篇论文为大数据时代的到来铺平了道路,让存储和分析海量信息成为可能。

2006年,辛顿师生正式提出“深度学习(DL)”的概念,并详细阐述了解决“梯度消失”问题的方案:他们首先采用无监督学习方法逐层训练算法,随后利用有监督的BP算法进行调优。该方法的提出,开启了 DL在学术界和工业界的浪潮。

2010年,潘嘉林和杨强教授发表了关于迁移学习的研究,迁移学习使计算机能利用已有知识,快速适应新任务。好比是我们学会了开车后,换一辆新车也会驾驶。

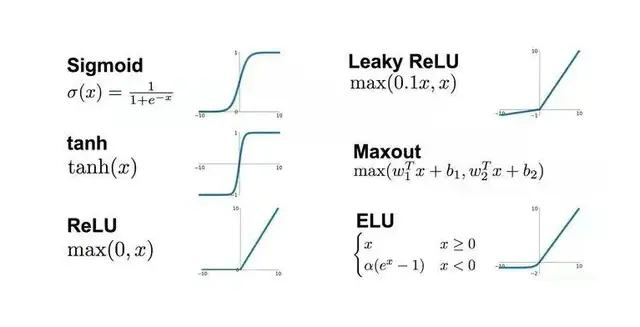

2011年,ReLU线性整流函数被提出,其更有效地控制了梯度下降和反向传播过程中的问题,从而有效避免了梯度爆炸和消失的问题。同一年, Google采用DNN将语音识别错误率降到30%以内。这是语音识别领域十几年来最大的突破。

2012年,辛顿师生设计的AlexNet在ImageNet竞赛中大放异彩。他们的神经网络赋予了计算机艺术家的视觉能力,让AI在图片识别方面达到了全新的水平。

这一成就不仅让辛顿师生三人被谷歌招致麾下,更使谷歌在AI领域的地位一跃而起,成为行业的领军企业。

随着深度学习和迁移学习的不断发展,未来的AI将会如何改变我们的生活?让我们拭目以待!