探索蛋白质动态结构的奥秘,不仅是推动新药研发的关键一步,更是理解生命过程的重要基石。然而,蛋白质的复杂性让人们难以直接捕捉并解析其深层结构信息,如何将错综复杂的生物数据转化为直观易懂的表达形式,一直是科研领域的一大难题。

随着语言模型 (LM) 的飞跃式发展,一个创新的想法应运而生:既然语言模型能够从大量数据中学习和提取文本信息,那能否从蛋白质数据中学会「阅读」蛋白质信息,直接将动态的蛋白质结构信息变成人类容易理解的文本叙述?

这一极具发展潜力的想法在实际应用时却遇到了诸多挑战,例如,语言模型在蛋白质序列的文本语料库上进行预训练,虽然具备很强的文本处理能力,但在理解蛋白质结构这种非人类「语言」时,显得力不从心。相反,蛋白质语言模型 (PLMs) 在蛋白质序列语料库上进行预训练,具有优秀的蛋白质理解与生成能力,但它的局限性同样显著——缺乏文本处理能力。

如果能够融合 PLMs 与 LM 的优势,构建一种既能深入理解蛋白质结构,又能无缝对接文本信息的全新模型架构,将对药物研发、蛋白质性质预测、分子设计等领域产生深远的影响。然而,蛋白质结构与人类语言文本分属不同的数据模态,想要突破壁垒进行融合并非易事。

对此,中国科学技术大学王翔,联合新加坡国立大学刘致远团队、北海道大学研究团队提出了一个全新的蛋白质-文本建模框架 ProtT3,该框架通过跨模态投影器,将具有模态差异的 PLM 与 LM 结合,其中,PLM 用于蛋白质理解,LM 用于文本处理。为实现高效微调,研究人员在 LM 中融入了 LoRA ,有效地调节了蛋白质到文本 (protein-to-text) 的生成过程。

此外,研究人员还为蛋白质-文本建模任务建立了定量评估任务,包括蛋白质字幕 (protein captioning)、蛋白质问答 (protein QA)、蛋白质-文本检索 (protein-text retrieval),ProtT3 在这 3 类任务中均取得了优异性能。

该研究以「ProtT3: Protein-to-Text Generation for Text-based Protein Understanding」为题,入选顶会 ACL 2024。

研究亮点:

* ProtT3 框架可弥合文本和蛋白质之间的模态差距,提升蛋白质序列的解析准确性

* 蛋白质字幕任务中,ProtT3 在 Swiss-Prot 和 ProteinKG25 数据集上的 BLEU-2 分数比基线高出 10 分以上

* 蛋白质问答任务中,ProtT3 在 PDB-QA 数据集上的精确匹配性能提高了 2.5%

* 蛋白质-文本检索任务中,ProtT3 在 Swiss-Prot 和 ProteinKG25 数据集上的检索准确性比基线高 14% 以上

论文地址:

https://arxiv.org/abs/2405.12564

数据集下载地址:https://go.hyper.ai/j0wvp

开源项目「awesome-ai4s」汇集了百余篇 AI4S 论文解读,并提供海量数据集与工具:https://github.com/hyperai/awesome-ai4s

面向蛋白质研究的 3 大数据集构建与优化研究人员选取了 Swiss-Prot、ProteinKG25、PDB-QA 3 个数据集。

蛋白质文本数据集的统计数据

如上表所示,Swiss-Prot 是一个带有文本注释的蛋白质序列数据库,研究人员对数据集进行处理,并从文本注释中排除了蛋白质名称,以防止信息泄露。生成的文本描述连接蛋白质功能、位置和家族的注释。

ProteinKG25 是 Gene Ontology 数据库派生出的知识图谱。研究人员首先将相同蛋白质的 triples 聚合起来,然后将蛋白质信息填充到预定义的文本模板中,将其 triples 转换为自由文本。

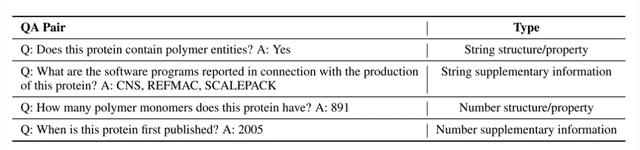

PDB-QA 是从 RCSB PDB2 派生的蛋白质单轮问答数据集,包含关于蛋白质结构、性质和补充信息的 30 个问题模板。如下表所示,为了进行细粒度的评估,研究人员根据答案的格式(字符串或数字)和内容焦点(结构/属性或补充信息)将问题分为 4 类。

PDB-QA 数据集中的 QA 对样本

ProtT3:一种创新的蛋白质到文本生成模型架构如下图 a 所示,ProtT3 由蛋白质语言模型 (Protein Language Model, PLM)、跨模态投影器 (Cross-ModalProjector)、语言模型 (LM)、 LoRA 模块组成,有效地调节蛋白质到文本 (protein-to-text) 的生成过程。

ProtT3 框架

其中,研究人员选择的蛋白质语言模型是 ESM-2150M,用于蛋白质理解;选择的跨模态投影器是 Q-Former,用来桥接 PLM 和语言模型 LM 之间的模态差异,进而将蛋白质表示映射到 LM 的文本空间中;选择的语言模型是 Galactica1.3B,用于文本处理;为保持下游适应 (downstream adaptation) 的效率,研究人员还在语言模型中融入了 LoRA ,以实现高效的微调。

如下图 b,ProtT3 采用两个训练阶段来增强蛋白质文本的有效建模,分别是蛋白质-文本检索训练 (Protein-Text Retrieval Training)、蛋白质到文本的生成训练 (Protein-to-Text Generation Training)。

ProtT3 的两个训练阶段

* 第一阶段:蛋白质-文本检索训练

如下图 a 所示,跨模态投影器 Q-Former 由两个 transformers 组成:Protein transformers 用于蛋白质编码,Text transformers 用于文本处理。两个 transformers 共享自注意力 (self-attention),以实现蛋白质和文本之间的交互。

Q-Former 的架构和三个训练任务

研究人员在 Swiss-Prot 和 ProteinKG25 的组合数据集上训练 ProtT3,以进行蛋白质-文本检索,分别涉及 3 个任务:蛋白质-文本对比 (protein-text contrasting)、蛋白质-文本匹配 (protein-text matching, PTM) 和蛋白质字幕 (protein captioning, PCap)。

* 第二阶段:蛋白质到文本的生成训练

研究人员将跨模态投影器连接到语言模型 (LM),把蛋白质表示 Z 输入语言模型,以便通过蛋白质信息来调节文本生成过程。其中,研究人员使用线性层将 Z 投影到语言模型输入的相同维度,分别为每个生成数据集训练 ProtT3,并在蛋白质表示后添加不同的文本提示,进一步控制生成过程。

此外,研究人员引入了 LoRA ,在蛋白质到文本生成任务上对 3 个数据集进行单独的微调。

蛋白质领域的全能选手,评估 ProtT3 在 3 大任务中的性能为了评估 ProtT3 的性能,研究人员在蛋白质字幕 (protein captioning)、蛋白质问答 (protein QA)、蛋白质-文本检索 (protein-text retrieval) 这 3 类任务中进行了测试。

更接近蛋白质的真实描述,ProtT3 准确率更高

研究人员在 Swiss-Prot 和 ProteinKG25 数据集上评估了 LoRA 微调的 Galactica1.3B、ProtT3 w/ MLP Proj.、ProtT3 w/o stage 1、ProtT3 模型在蛋白质字幕任务上的性能,并使用 BLEU、ROUGE、METEOR 作为评估指标。

* ProtT3 w/ MLP Proj.:ProtT3 的变体,用 MLP 代替 ProtT3 的跨模态投影器

* ProtT3 w/o stage 1:ProtT3 的变体,跳过 ProtT3 的训练阶段 1

如下图所示,与 LoRA 微调 Galactica1.3B 相比,ProtT3 在 BLEU-2 分数上提高了 10 分以上,直观展示了引入蛋白质语言模型的重要性,以及 ProtT3 在理解蛋白质输入方面的有效性。此外,ProtT3 的不同指标均优于其两个变体,这表明使用 Q-Former 投影器和训练阶段 1 的优势。

蛋白质字幕性能,粗体表示最佳性能

下图展示了 Ground truth、ProtT3、Galactica 的 3 个蛋白质字幕生成示例。在 Q8CFG4 示例中,ProtT3 的标注内容更准确地识别了 DMRT 家族,而 Galactica 则没有。在 P46427 示例中,这两个模型都未能识别出蛋白质的功能,但 ProtT3 对蛋白质家族的预测更准确。在 Q9LY66 示例中,两个模型都成功地预测了亚细胞位置和蛋白质家族。ProtT3 更进一步地预测了蛋白质的功能,更接近真实描述。

来自 Swiss-Prot. 的 Protein captioning 示例蓝色部分与实际情况完全匹配,蛋白质结构图由 AlphaFold2 产生

准确率比基线模型高 14%,ProtT3 蛋白质-文本检索能力更优

研究人员在 Swiss-Prot 和 ProteinKG25 数据集上评估了 ProtT3 在蛋白质-文本检索的性能,使用准确率和 Recall@20 作为评估指标,并采用 ProtST 和 ProteinCLAP 作为基线模型。

如下表所示,ProtT3 的准确率比基线模型高出 14% 以上,这表明 ProtT3 在蛋白质与其对应文本描述的对齐能力更优。此外,蛋白质-文本匹配 (PTM) 将 ProtT3 的准确率提高了 1%-2%,这是因为 PTM 允许蛋白质和文本信息在 Q-Former 的早期层 (early layers) 进行交互,从而实现更细粒度的蛋白质-文本相似性度量。蛋白质字幕 (PCap) 将 ProtT3 的检索准确率提高了约 2%,这是因为 PCap 鼓励 query tokens 提取与文本输入最相关的蛋白质信息,有助于蛋白质-文本的对齐。* ProtT3 w/o PTM:跳过 ProtT3 的 PTM 阶段

* ProtT3 w/o PCap:跳过 ProtT3 的 PCap 阶段

蛋白质文本检索性能。粗体表示最佳性能,下划线表示次佳性能P2T 是蛋白质到文本检索,T2P 是文本到蛋白质检索

可预测蛋白质结构和性质,ProtT3 具备更优秀的问答能力

研究人员在 PDB-QA 数据集上评估了 ProtT3 的蛋白质问答性能,选择精确匹配 (exact match) 作为评估指标,采用 LoRA 微调的 Galactica1.3B 作为基线模型 (LoRA ft)。

如下图所示,ProtT3 的精确匹配性能比基线高出 2.5%,在预测蛋白质结构和性质方面始终优于基线,这证明 ProtT3 具备优秀的理解蛋白质和文本问题的多模态能力。

蛋白质 QA 的精确匹配性能QA 分类:SP 代表结构/属性,SI 代表补充信息,ft 代表微调

如下图所示,在以下 3 个蛋白质问答示例中,ProtT3 和 Galactica 都正确地回答了关于蛋白质性质/结构的前两个问题,但在需要数字答案的第三个问题上失败了,ProteinChat 在 3 个问题上都遇到了困难,未能回答出任何一个。

PDBQA 数据集中的蛋白质 QA 结果示例,蓝色为正确预测

解锁蛋白质语言,LLM 在生命科学中的前沿探索研究人员在蛋白质到文本生成领域的探索,能够让人类用可理解的方式来解锁复杂的生物现象。上述研究中的语言模型不仅展现了对蛋白质「潜在空间」的深刻理解,更是作为连接生物医学任务与自然语言处理的桥梁,为药物研发与蛋白质功能预测等研究开辟了新路径。进一步地,如果用那些具有数十亿乃至更多参数的大语言模型处理更复杂的语言结构,将有望从多个层次提升生命科学的未来探索。

比如,浙江大学张强、陈华钧团队曾提出了一种创新的大语言模型 InstructProtein,该模型具备人类语言和蛋白质语言的双向生成能力:(i) 将蛋白质序列作为输入,预测其文本功能描述;(ii) 使用自然语言提示蛋白质序列生成。

具体而言,研究人员在蛋白质和自然语言语料库中对 LLM 进行预训练,然后采用有监督的指令调整来促进这两种不同语言的对齐。InstructProtein 在大量双向蛋白质文本生成任务中表现优异,它在基于文本的蛋白质功能预测和序列设计方面迈出了开创性一步,有效地缩小了蛋白质与人类语言理解之间的差距。

该论文以「InstructProtein: Aligning Human and Protein Language via Knowledge Instruction」为题,入选 ACL 2024。* 论文原文:https://arxiv.org/pdf/2310.03269

此外,悉尼科技大学团队也曾与浙江大学研究团队强强联合,共同推出了大语言模型 ProtChatGPT。该模型通过学习和理解蛋白质结构,允许用户上传蛋白质相关的问题并参与互动对话,最后产生全面的答案。

ProtChatGPT 框架

具体而言,蛋白质首先经过蛋白质编码器 (protein encoders) 和蛋白质语言预训练转换器 (PLP-former) 以生成蛋白质嵌入,然后这些嵌入通过投影适配器 (Projection Adapter) 投影到 LLM。最后,LLM 将用户问题与投影嵌入相结合,从而生成信息丰富的答案。实验表明,ProtChatGPT 可以对蛋白质及其相应问题产生专业的回复,为蛋白质研究的深入探索与应用拓展注入了新的活力。* 论文原文:https://arxiv.org/abs/2402.09649

未来,当大语言模型能够利用海量且丰富的数据,推断出远远超过人类认知极限的蛋白质潜在规律或深层结构时,它们的潜力将会被极大释放,我们期待,随着技术的不断进步,大语言模型将引领蛋白质研究迈向一个更加璀璨的未来。