1、专为具身智能量身打造!售价仅为千元级!思岚科技推出一体化3D定位建图传感器,让空间定位感知方案全面步入三维6DOF时代

近日,科技领域再传喜讯,思岚科技震撼发布革命性一体化3D定位建图解决方案 ——“SLAMTEC Aurora/思岚智见”。它的发布,正式将空间定位感知方案全面步入三维6DOF时代,并量身为具身智能打造。

在应用场景上,Aurora具有广泛的适用性。无论是人形机器人、四足机器人的精准定位,户外低速设备的自主导航,还是割草机的智能作业,环境测绘的精细描绘,甚至是无GPS条件下的高精度定位,Aurora都能提供稳定可靠的解决方案。甚至在建筑工程领域,Aurora也同样能够发挥重要作用,助力工程的精准施工和高效管理。

思岚首创,定位建图全面步入3D时代

针对现在室外复杂环境的应用,思岚科技创新融合激光、视觉、惯性导航以及深度学习技术整合为一。这一革命性的设计,成功打破了无人驾驶和机器人行业中激光与视觉技术长期分立的僵局,实现了二者的完美协同。

无需外部依赖通电即用

SLAMTEC Aurora操作简便,搭载在人形机器人上仅需三步:安装,开机,采集信息。

AI +SLAM

深度学习加持,无惧苛刻挑战

行业内首个产品级融合了深度神经网络的导航定位系统,提供高于传统SLAM系统性能的表现。

▍在草地环境定位建图稳定出色

面对高低起伏的草地环境,传统方案常陷入困境甚至“跑飞”,而Aurora能够有效排除草地环境中的干扰因素,敏锐地感知环境中的每一处细微特征,持续输出高质量定位和建图数据。

【传统方案定位丢失】

【Aurora方案定位稳定】

▍高速运动不慌乱,尽显非凡稳定

得益于深度学习高度的空间定位能力,即使遭遇高速旋转或意外加速,Aurora始终进行毫秒级的定位捕捉,保持稳定如一。

▍机器狗和人形机器人的好搭档

Aurora具备完全的3D空间定位能力,并无需外部依赖,通电即用,专为具身智能而生,可以从容应对室内外各类复杂环境和地形。

▍拓展无限可能,无惧高速和黑暗环境

SLAMTEC Aurora在车载环境的高速移动和黑暗条件下,依然工作出色。

▍挑战内环建图,前所未有的性能体验

同时,Aurora还具备超大感知范围和建图面积,可为智能设备在复杂环境中提供精准的空间感知能力。在性能测试中,思岚科技以上海内环线为测试场地,使用Aurora成功完成了面积达120平方公里,全线长度达47.7公里的上海市内环线的建图和闭环。

同步2D高精地图输出

思岚科技结合多年耕耘机器人导航定位的经验深知,如果将现有技术体系无缝迁移至关重要。因此,Aurora同步具备输出2D高精度激光建图的能力,可以帮助现有导航算法无缝迁移到室外3D环境,加速开发进程。

【室外建图-2D激光输出】

【室外建图-3D点云输出】

精致小巧,轻松嵌入

SLAMTEC Aurora保持强大性能的同时,拥有紧凑的机身设计,手掌大小,重量仅 500g,既不占用过多空间,又能发挥巨大的作用。无论是嵌入小型机器人中,还是与大型设备集成,它都能轻松适应,成为具身智能的最佳伙伴。

更为重要的是,Aurora的操作极为简便。只需安装、开机、采集信息简单的三步,Aurora即可开始工作。这种设计大大降低了使用门槛,使得即便是非专业用户也能快速上手。

千元级传感器,让3D定位建图不再高不可攀

与高精度定位建图传感器同一起跑线,卓越的性能仅需千元级的价格,Aurora 让曾经高不可攀的 3D 定位建图技术变得触手可及。

如果您对我们传感器感兴趣,发送您的产品需求至sales@slamtec.com,或者拨打4009009557,我们将第一时间与您联系。

▍关于思岚科技

思岚科技成立于2013年,公司核心业务包括传感器激光雷达、自主定位导航解决方案SLAMWARE以及机器人通用底盘等板块。思岚科技核心研发团队在机器人自主定位导航及核心传感器方面拥有丰富的研发和实践经验,也因此,思岚科技目前的SLAM技术处于行业领先地位,能够实现百万平米级别的实时地图构建能力,构建精度达到毫米级别。

目前,思岚科技的产品线主要涵盖三大核心领域:360°扫描测距激光雷达RPLIDAR、模块化自主定位导航系统SLAMWARE,以及通用型服务机器人平台ZEUS。其业务版图覆盖全国多个省份和城市,并参与包括微软、壳牌、优必选、科大讯飞、软银等企业的服务机器人项目研发中。作为“新质生产力”的代表,思岚科技近几年积极响应出海战略,业务遍布亚洲、欧洲、北美等全球40多个国家和地区,服务企业用户超过 3000 家、个人用户累计超过 10 万,已成为智能移动机器人、自动驾驶、元宇宙等主流客户值得信赖的方案商。

2、会议通知|2024年中国(杭州)国际机器人西湖论坛暨二届二次会员大会!

协会简介

浙江省机器人产业发展协会(Zhejiang Robot Industry Association,简称ZRIA)是在省政府的关怀与相关部门的指导下,于2015年9月在浙江省机器人产业技术联盟的基础上发起成立的,是由省民政厅认定的省内唯一的省级机器人行业组织。协会汇集了省内200多家机器人领域的知名企业、高等学府和科研机构,是浙江省机器人科技与产业领域的中坚力量。协会会长由著名的机器人专家学者、浙江大学党委副书记、浙江大学机器人研究院院长朱世强教授担任。协会为会员提供的服务主要有政策解读、行业研究、标准制定与推广、技术成果鉴定、企业品牌建设、教育培训等,旨在打造一个“产学研用金”协同创新平台,推动机器人产业全面发展。

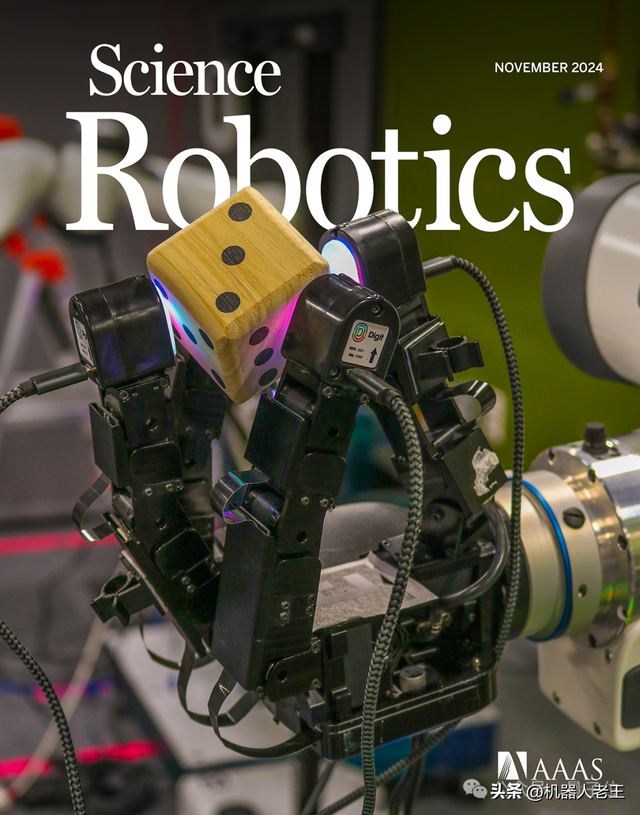

3、Science|Meta最新触觉机械手操作未知物体精度最高提升94%

现在,随便丢给机械手一个陌生物体,它都可以像人类一样轻松拿捏了——

除了苹果,罐头、乐高积木、大象玩偶、骰子,都不在话下:

来自Meta FAIR团队最新的NeuralFeels技术,通过融合触觉和视觉,机械手可以更精确地操作未知物体,精度最高提升了94%!这项研究还登上了Science Robotics的封面,团队同时也公开了包含70个实验的新测试基准FeelSight。

如何让机械手精确操作未知物体?

让机械手拿取常见的魔方、水果等早已是基操,但如何让机器人更好地操作未知物体一直是一个研究难题。

一个重要原因是目前的机械手训练都太过于依靠视觉,并且仅限于操作已知的先验物体,而现实中很多时候物体都会受到视觉遮挡,导致训练往往进步缓慢。

对此,团队研发出一种名为NeuralFeels的创新技术,为机器人在复杂环境中的物体感知与操作带来了新的突破。

这究竟是怎么做到的呢?让我们来一起看一下技术细节——

融合了触觉的多模态感知

NeuralFeels技术的创新之处在于结合了视觉和触觉,通过多模态融合的方式,让机器手能够对未知物体持续进行3D建模,更精确地估计手持操作中物体的姿态和形状。

具体的处理流程如下图所示,前端实现了视觉和触觉的鲁棒分割和深度预测,而后端将此信息结合成一个神经场,同时通过体积采样进一步优化姿态。

而在遮挡视角下,视觉与触觉融合有助于提高跟踪性能,还可以从无遮挡的局部视角进行跟踪。团队在摄像机视角的球面上量化了这些收益。

从下图中可以观察到,当视觉严重遮挡时,触觉的作用更大,而在几乎没有遮挡时,触觉会发挥微调作用。

前端深度学习策略

首先来看看NeuralFeels技术的前端(Front end),它采用了基于深度学习的分割策略和触觉Transformer,可以精确提取目标对象深度。

用运动学分割一切神经优化非常依赖分割对象的输入深度,所以团队将前端设计成能够从视觉中鲁棒地提取对象深度的形式。深度在RGB-D相机中是现成的,但为了应对严重遮挡的问题,团队还引入了一种基于强大视觉基础模型的动力学感知分割策略。

触觉Transformer

触觉Transformer最近有研究表明,在自然图像中使用ViT进行密集深度预测更有效,于是团队提出了一种触觉Transformer,用于通过视觉触觉预测接触深度,这个Transformer完全在模拟中训练,可在多个真实世界的DIGIT传感器上通用。机械手可以用嵌入式摄像头直接感知发光的胶垫,通过监督学习获得接触深度。

后端姿势优化

NeuralFeels的后端(Back end)部分通过使用Theseus中的自定义测量因子,将前端的中间输出转化为非线性最小二乘问题进行优化。

形状和姿态优化器后端模块从前端模块得到中间输出,并在线构对象模型。这个过程将交替使用来自视觉-触觉深度流的样本进行地图和姿态优化步骤。在本研究的地图优化器中,即时NGP模型的权重可以完全描述物体的3D几何结构。

神经SLAM

神经SLAM在现实世界和模拟中,团队构建了一个不断演进的神经SDF,它整合了视觉和触觉,并可以同时跟踪物体。下图展示了对应的RGB-D和触觉图像的输入流,以及相应的姿态重建。

神经跟踪:给定形状的对象姿态估计

神经跟踪:给定形状的对象姿态估计当目标对象存在对应的CAD模型时,NeuralFeels可以实现优秀的多模态姿态跟踪能力。此时目标对象的SDF模型是预先计算的,NeuralFeels会冻结神经场的权重,仅使用前端估计进行视觉-触觉跟踪。

NeuralFeels大大提升了机械手性能

为了评估NeuralFeels技术的性能,研究团队在模拟和真实世界环境中进行了多次实验,涉及14种不同物体,相关测试集FeelSight也已发布!

实验中使用了多种评估指标,包括用于评估姿势跟踪误差的对称平均欧几里得距离(ADD-S),以及用于衡量形状重建精度和完整性的F分数等。

结果非常令人惊喜,NeuralFeels技术在以下3个方面都有非常出色的表现:

1.物体重建精度大幅提升

在物体重建方面,研究发现结合触觉信息后,表面重建精度在模拟环境中平均提高了15.3%,在真实世界中提高了 14.6%。

最终重建结果在模拟环境中的中位误差为2.1毫米,真实世界中为3.9毫米。这表明NeuralFeels技术能够有效地利用触觉信息补充视觉信息,更准确地重建物体形状。

2.物体姿态跟踪更加精准

在物体姿态跟踪方面,NeuralFeels技术相比仅使用视觉信息的基线方法有显著改进。

在模拟环境中,姿态跟踪精度提高了21.3%,真实世界中提高了26.6%。

在已知物体形状的姿态跟踪实验中,即使存在不精确的视觉分割和稀疏的触摸信号,该技术也能实现低误差的姿态跟踪,平均姿态误差可降至2毫米左右。

并且,触觉信息在降低平均姿态误差方面发挥了重要作用,在模拟环境中可使误差降低22.29%,在真实世界中降低 3.9%。

3.应对复杂场景表现出色

在面对严重遮挡和视觉深度噪声等具有挑战性的场景时,NeuralFeels技术同样表现非常出色。

在模拟的200个不同相机视角的遮挡实验中,平均跟踪性能提升 21.2%,在严重遮挡情况下提升幅度可达94.1%!

在视觉深度噪声模拟实验中,随着噪声增加,融合触觉信息能有效降低误差分布,使机器人在视觉信息不理想的情况下仍能准确跟踪物体姿态。

研究意义

NeuralFeels技术的创新之处在于它融合了多模态数据、并结合了在线神经场,这些技术让机器人能够在操作未知物体时实现更准确的姿态跟踪和形状重建。

而且,与复杂的传感器相比,团队使用空间感知组合所需的硬件更少,也比端到端感知方法更容易解释。

尽管目前在一些方面仍存在改进空间,如在长期跟踪中由于缺乏闭环检测可能导致小误差累积,但对于提升机械手操作精度的效果非常显著,

未来,研究人员计划进一步优化技术,例如通过基于特征的前端获取更粗略的初始化,加入长期闭环检测以减少姿态误差的累积,通过控制神经SLAM的输出进行通用灵巧性研究等。

这样一来,家庭、仓库和制造业等复杂环境中作业的机器人的性能都有可能得到极大的提升了!

参考资料:[1]https://www.science.org/doi/10.1126/scirobotics.adl0628[2]https://suddhu.github.io/neural-feels/

文章来源:量子位