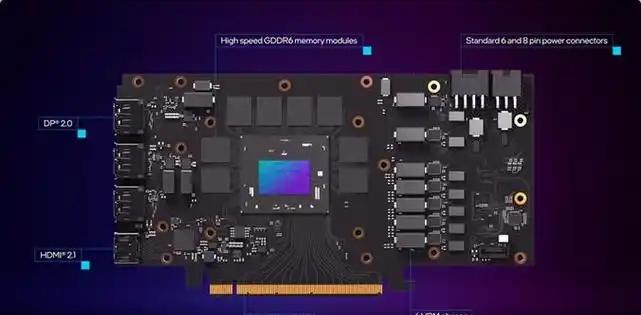

【[102星]ExlLlamaV3:为现代消费级GPU优化的本地运行LLMs的量化和推理库。亮点:1. 支持多种架构,适配更多模型;2. EXL3量化格式,高效转换,仅需几分钟到几小时;3. 低内存需求,70B模型仅需16GB显存】

'An optimized quantization and inference library for running LLMs locally on modern consumer-class GPUs'

GitHub: github.com/turboderp-org/exllamav3

量化技术 LLMs优化 高效推理 AI创造营