DeepSeek发论文,又有新技术

华尔街见闻报道,18日,DeepSeek CEO公布了一项由梁文锋亲自参与的研究论文成果——原生稀疏注意力(Native Sparse Attention, NSA)机制。这是DeepSeek团队在稀疏注意力领域的创新性工作,结合了算法创新和硬件优化,旨在解决长上下文建模中的计算瓶颈。

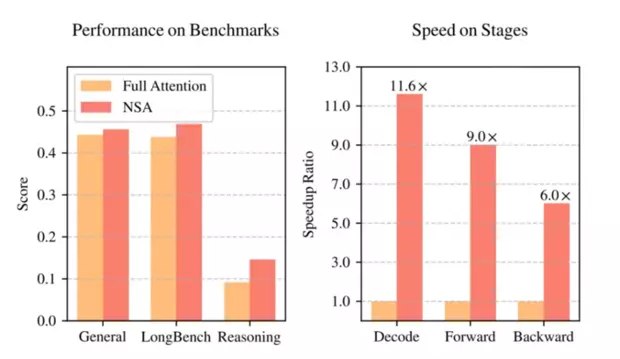

DeepSeek论文显示,NSA不仅将大语言模型处理64k长文本的速度最高提升11.6倍,更在通用基准测试中实现性能反超传统全注意力模型。在全球AI竞赛转向"硬核创新"的当口,这家低调的中国公司展示了技术破局的新范式。

值得注意的是,NSA尚未应用于DeepSeek V3的训练中。这意味着,如果后续DeepSeek将NSA整合到模型训练中,其基座模型的能力有望实现显著提升。论文中明确指出:“使用NSA预训练的模型超过了全注意力模型”。

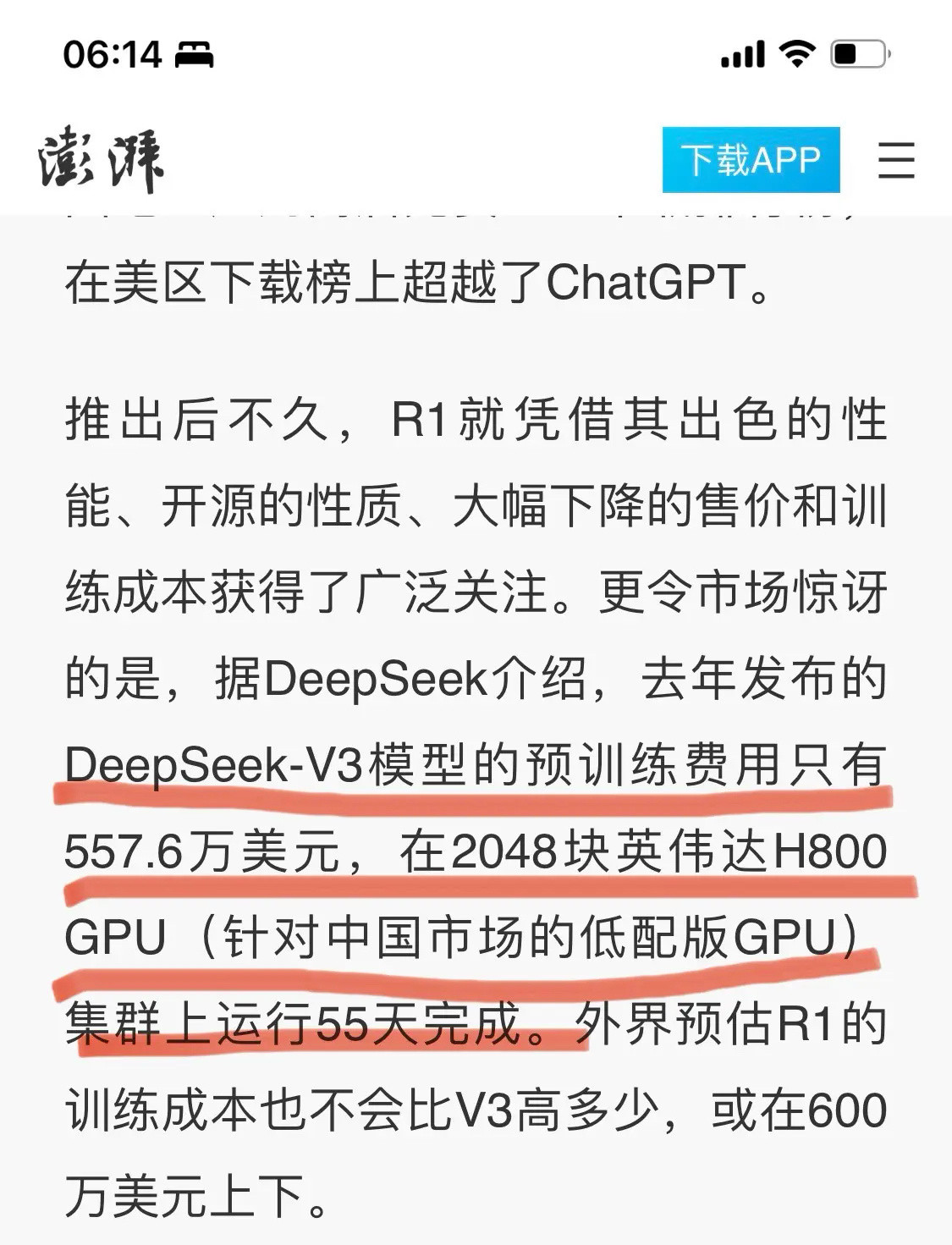

与DeepSeek形成鲜明对比的是,xAI选择了另一条道路:对工程规模的极致追求。今日马斯克发布的Grok3使用了20万块GPU集群,而未来的Grok4更是计划使用百万块GPU、1.2GW的集群。这种“财大气粗”的做法,体现了北美在AI领域一贯的“大力出奇迹”风格。

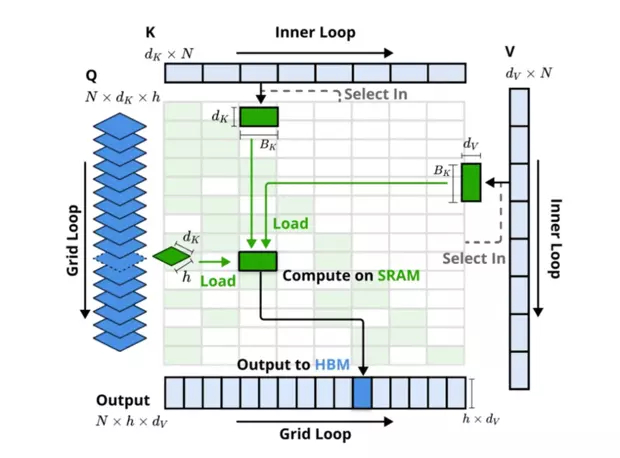

科技自媒体分析,NSA架构采用了分层Token建模,通过三个并行的注意力分支处理输入序列:

1压缩注意力(Compressed Attention):通过压缩Token块来捕获全局信息,处理粗粒度的模式。

2选择注意力(Selected Attention):处理重要的Token块,选择性地保留细粒度的信息。

3滑动窗口注意力(Sliding Window Attention):处理局部上下文信息。

这三个分支的输出通过一个门控机制进行聚合。为了最大化效率,NSA还专门设计了硬件优化的Kernel。

具体而言,NSA在Token Compression部分,基于block粒度进行压缩计算,并插入位置信息编码。在Token Selection部分,则巧妙地借用Compression的注意力分数作为block的重要性分数,进行top-N选择,以保留关键的细粒度信息。Sliding Window部分则负责处理局部上下文。最后,通过Gating函数综合三种注意力的输出。

根据DeepSeek发布的实验数据,NSA技术在多个方面展现出卓越表现。

在通用基准测试、长文本任务和指令推理方面,使用NSA预训练的模型性能不仅没有下降,反而超越了Full Attention模型。更重要的是,在处理64k长度的序列时,NSA在解码、前向传播和反向传播等各个阶段都实现了显著的速度提升,最高可达11.6倍,证明了NSA在模型生命周期各个阶段的效率优势。