如果你最近一直在关注英特尔、AMD的新CPU,可能会注意到,无论是酷睿Ultra还是锐龙8000G,为了迎接AI时代挑战,都在新的产品中具备了NPU模块。你可能会问:什么是 NPU,为什么我需要 NPU?

神经网络与神经网络算法

NPU,是“神经网络处理单元”的缩写。因此,要了解NPU,就必须知道什么是神经网络,它在AI技术和应用中扮演什么角色。

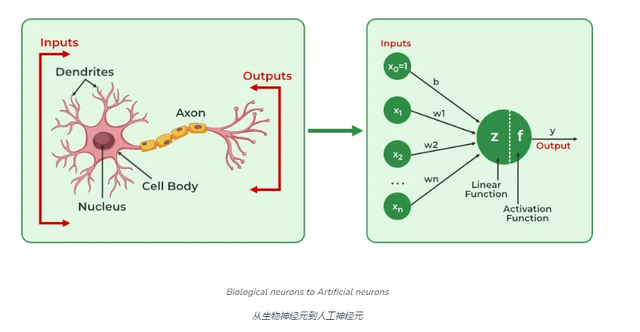

神经网络是一种模仿人脑神经元结构的计算模型,用于识别模式和处理复杂的数据。它由大量的节点(类似于神经元)组成,这些节点通过连接(类似于突触)相互作用。

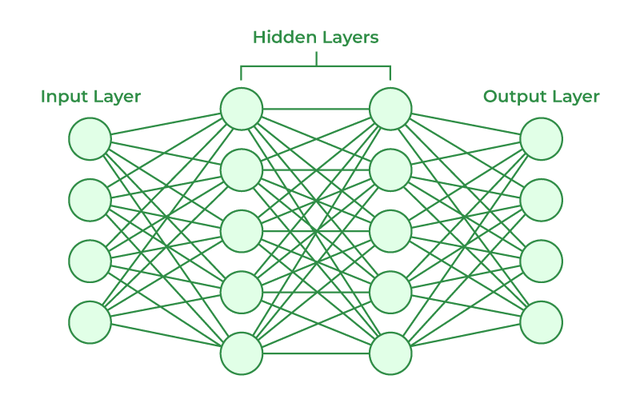

人工神经网络包含被称为单元/节点的人工神经元。这些单元排列在一系列层中,共同构成系统中的整个人工神经网络。一层可以只有十几个单元,也可以有数百万个单元,这取决于复杂的神经网络需要如何学习数据集中的隐藏模式。

通常,人工神经网络有输入层、输出层和隐藏层。输入层接收神经网络需要分析或学习的外界数据。然后,这些数据经过一个或多个隐藏层,将输入转化为对输出层有价值的数据。最后,输出层以人工神经网络对输入数据的响应形式提供输出。

每个连接都有一个权重,代表信息传递的强度。通过这种方式,神经网络能够学习和存储信息,对输入数据进行分类、识别和预测。

例如,对人脑来说,学习发生在细胞核或体细胞内,体细胞内有一个帮助处理冲动的核。如果冲动的强度足以达到阈值,就会产生动作电位并通过轴突。突触的可塑性代表了突触随着时间的推移随着其活动的变化而变强或变弱的能力。

而在人工神经网络中,反向传播是一种用于学习的技术,它会根据预测结果和实际结果之间的误差或差异调整节点之间的权重,也就是通过调整网络中的权重,使得网络能够更准确地完成特定的任务,如图像识别、语音识别和自然语言处理等。深度学习,作为神经网络算法的一个重要分支,通过使用多层(深层)的网络结构,能够处理更加复杂的数据和任务。

在人工智能领域,尤其是生成式人工智能中,神经网络和神经网络算法扮演着至关重要的角色。生成式人工智能指的是能够创造新内容的AI系统,如自动写作、绘画、音乐创作等。这些系统通常依赖于深度神经网络,通过学习大量的数据样本,生成新的、类似的真实世界内容。

晕了?举个例子

假设你想教一个AI通过人工神经网络识别猫,然后向它展示成千上万张不同的猫的图片,试图让网络学会识别猫。一旦使用猫的图像对神经网络进行了足够的训练,就需要检查它是否能正确识别猫的图像。

具体做法是让神经网络对所提供的图像进行分类,判断这些图像是否为猫图像。人工智能网络获得的输出结果将通过人类提供的图像是否为猫图像的描述来证实。如果自动识别网络识别错误,就会使用反向传播来调整它在训练过程中学到的知识。

单个神经元可能会专门识别图形某一部分特征并和其他节点“交流”

例如,设定学习识别过程中,识别正确猫咪,加1分;错误,不得分或者扣分。那么神经网络就会通过不同神经元所处理的图片的信息进行交换,不断归纳总结出“猫”的形象特点,去掉与猫无关的图像信息,期待正确识别,获得高分,以及如何识别得更快,让得分效率更高,这个过程一直持续到人工神经网络能以最小的错误率正确识别图像中的猫为止。

同样的原理,通过训练神经网络,生成式AI可以创作出新的音乐作品、编写文章或者生成逼真的图像。神经网络在生成式AI中的作用是学习和理解数据的内在结构,然后基于这些结构生成新的数据实例。

NPU登场

神经网络处理单元(NPU)是一种专门设计用于加速神经网络计算的处理器。与传统的中央处理单元(CPU)和图形处理单元(GPU)不同,NPU从硬件层面上针对AI计算进行了优化,以提高性能和能效。

Intel的NPU架构

NPU的工作原理是利用其专门设计的硬件结构来执行神经网络算法中的各种数学运算,如矩阵乘法、卷积等。这些运算是神经网络训练和推理过程中的核心操作。通过在硬件层面上进行优化,NPU能够以更低的能耗和更高的效率执行这些操作。

NPU与CPU、GPU的不同

CPU是通用处理器,设计用于执行广泛的计算任务。它具有强大的灵活性和可编程性,但可能在特定任务(如AI计算)上效率不高。

GPU最初设计用于处理图形和视频渲染,它擅长处理并行计算任务,因此在AI领域也得到了广泛应用。然而,GPU并非专门为AI计算设计,它在处理某些类型的AI任务时可能不如NPU高效。

简单来说,如下图,很容易说明三者不同:CPU是线性、串行任务(指令)执行,效率较低,通用性较高;GPU是并行处理和专用图形并行处理,效率更高;而NPU则是“并行认知处理”,在AI机器学习方面,效率更高。

与CPU和GPU相比,NPU在以下几个方面具有明显优势:

1. **性能**:NPU针对AI计算进行了专门优化,能够提供更高的计算性能。

2. **能效**:NPU在执行AI任务时,通常比CPU和GPU更加节能。

3. **面积效率**:NPU的设计紧凑,能够在有限的空间内提供高效的计算能力。

4. **专用硬件加速**:NPU通常包含专门的硬件加速器,如张量加速器和卷积加速器,这些加速器能够显著提高AI任务的处理速度。

CPU中包含NPU的意义

NPU的出现对于推动人工智能,特别是生成式人工智能的发展具有重要意义。随着AI应用的不断增多和深入,对计算资源的需求也在不断增长。在CPU中包含NPU,提供了一种高效、节能的解决方案,使得AI技术能够在各种设备上得到广泛应用,包括智能手机、自动驾驶汽车、智能家居等,可以更大限度解放CPU和GPU的负担,各司其职。

NPU的高效能和低能耗特性使得AI技术能够在移动设备上实现实时处理,为用户提供更加流畅和自然的交互体验。此外,NPU还有助于降低AI应用的部署成本,使得更多的企业和开发者能够利用AI技术创造新的价值。

总之,NPU作为AI时代的核心技术之一,不仅推动了人工智能技术的进步,也为各行各业带来了深远的影响。随着NPU技术的不断进步和优化,我们有理由相信,未来的AI应用将更加智能、高效和普及。