原文信息(包括题目、发表期刊、原文链接等):Learning to Warm-Start Fixed-Point Optimization Algorithms

原文作者:Rajiv Sambharya, Georgina Hall, Brandon Amos, and Bartolomeo Stellato

论文解读者:陈宇文

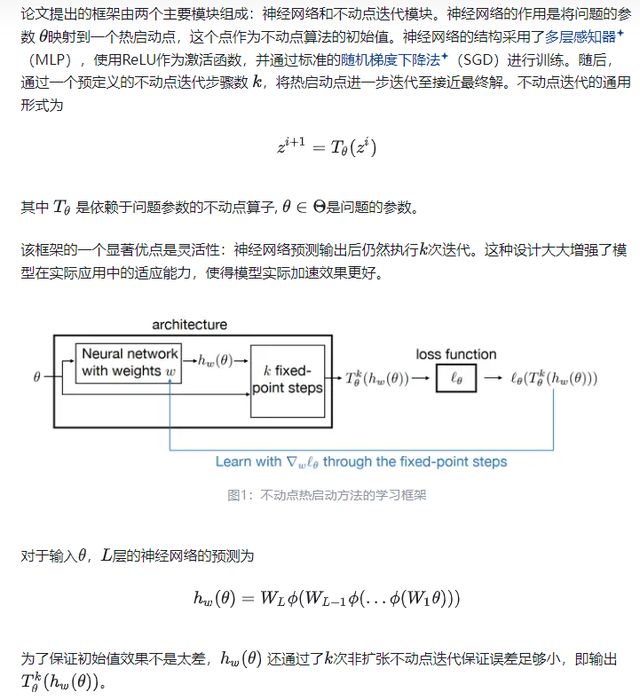

编者按:这篇论文《Learning to Warm-Start Fixed-Point Optimization Algorithms》提出了一种利用机器学习技术对不动点优化算法进行热启动的框架。不动点问题广泛存在于控制、机器学习、运筹学和工程学等领域,这些问题通常采用迭代法来求解。然而,传统的不动点迭代算法由于收敛速度慢,往往需要大量计算资源。为了提升这些算法的效率,该论文引入了一种基于神经网络的热启动方法,旨在降低初始解的误差,从而减少迭代次数来达到加快求解速度的目的。

一、背景与动机 二、框架设计

二、框架设计 三、损失函数与优化目标

三、损失函数与优化目标 四、理论分析与泛化保证

四、理论分析与泛化保证

五、实验验证与泛化效果

五、实验验证与泛化效果