今天享界S9首发华为ADS3.0,全场景全天候智能硬件感知系统。

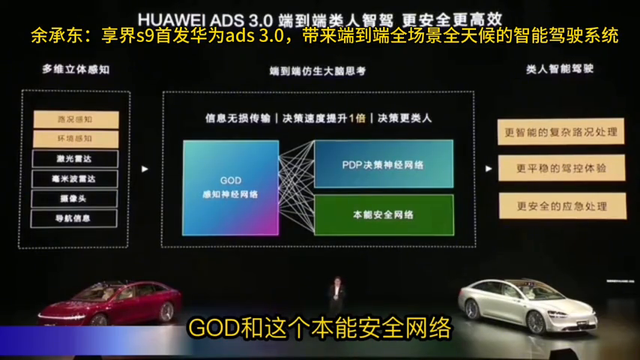

享界S9带来全场景全天候的智能硬件感知系统,最强的192线的激光雷达,最先进的毫米波雷达摄像头和整个环境感知整个系统ADS系统。这就是ADS3.0的架构,端到端的类人自驾更加安全、更加高效。

它在感知方面增强了在路况和环境的感知能力,最核心的就是中间这一块,就是端到端的仿生大脑。大家现在都讲端到端,从感知到规控决策这种端到端。但其实这种端到端不仅把信息无损传输,角色效率提升一倍,让角色更累人。

GOD有通用障碍物的感知神经网络和PDP角色神经网络进行端到端的处理,同时大家看里面框里还有个绿色的本能安全网络,待会我再给大家详细介绍GOD和本能安全网络带来的效果是什么样的。端到端的仿生大脑带来更累人的驾驶、自驾,更智能的复杂路况的处理,更平稳的驾控和更安全的应急处理。

首先打开了来看GOD这一块,大家知道ADS1.0这个时代还是BEV就鸟瞰,是把3D摄像,假如是一个两地的,不是一个深圳三地,是一个两地的,感知到ADS2.0,DV和GOD网络能够看到这种雾,可以看到这种路了。

但是到今天ADS3.0把它升级成GOD感知神经网络,对道路结构、目标、障碍物、场景理解都能够是有深深刻的这种能力,而且有全景的信息的感知和实时的、实况的行为的预判能力、判断判断能力,是真正的3D感知带给大家的。从物体识别到场景识别,真正更强大的感知系统。

这里边一个绿框本能安全网络,大家说这个是干什么的?我以前跟大家分享过,我派研发人员、专家到美国的加州,包括硅谷到美国的华盛顿州到西雅图,还到加拿大,在多个城市、多个地方进行了特斯拉的FSD的测试。

其实FSD的这种进步,最近的商用版本进步还是非常大的,它的上限还是挺高的,更加。但是有一个巨大的问题,它的下限很低。我们发现一个问题,就说人体测试,路上停的不静止不动的白色的货车,减都不减速,直接就撞过去了。还有绿色的货车,也不减速,也去撞,就是照静止的静止的车辆,它是白色的车辆,可能跟蓝天白云融成一体。

绿色的车辆按道理跟蓝天白云不一样,我还挺纳闷的,我说绿色的车应该是不是误解成树了,还是什么了,反正根本不减速,就撞上去了。还有开车的时候,撞路沿,这些你要知道,一旦出现一次事情,那就是车毁人亡,这个非常安全,是非常重要的。

大家知道现在chat g bd非常火热,chat bt包括四四欧都有一个共同的问题,大家知道什么?我们叫AI幻觉,AI幻觉什么意思?大概现在大模型现在就号称恰的VT算是最强的了,有30%左右的错误率。大家我不知道大家知不知道,至少有20%几,大概接近30%左右,20~20几到30左右的错误率。

但是在高速行驶的车上,一次错误就有可能车毁人亡,所以这一点是非常非常重要的。