“或许也有我的照片吗?”

“我女儿的照片会在里面吗?”

“我该把社交媒体平台中的自拍都删掉吗?”

“……”

将脸和淫秽物合成到一起的Deep Fake犯罪正让韩国女性人人自危。

N号房2.0卷土重来??近一个星期以来,韩国Deep Fake事件闹得沸沸扬扬,“韩国/换脸”不仅登上了中国热搜,也登上了其他国家的推特趋势。

4年前震惊世界的韩国“N号房”之恶,至今仍然历历在目!包括26名未成年人在内的74位受害者的性剥削视频,被分享给26万个会员用户......

而最近,如此巨大规模的性剥削犯罪,又在韩国卷土重来。

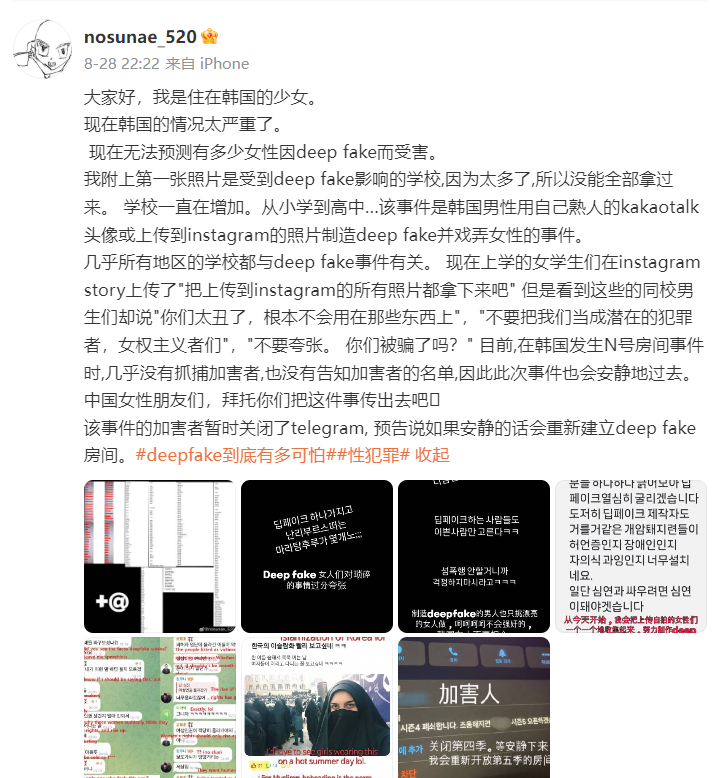

这两天有几名自称来自韩国的少女,使用翻译器等工具,在中文网络发出一条条求救信号:

“无法预测有多少女性因deep fake而受害”

“受到deep fake影响的学校太多了,从小学到高中一直在增加…”

“学校和国家让我们别在网上发布自己的照片”

“韩国社会需要关心...”

韩国DeepFake映射出的厌女文化所谓“DeepFake”,是指韩国男性用自己熟人的kakaotalk头像或上传到 ins 的照片制造假照、戏弄女性的事件。

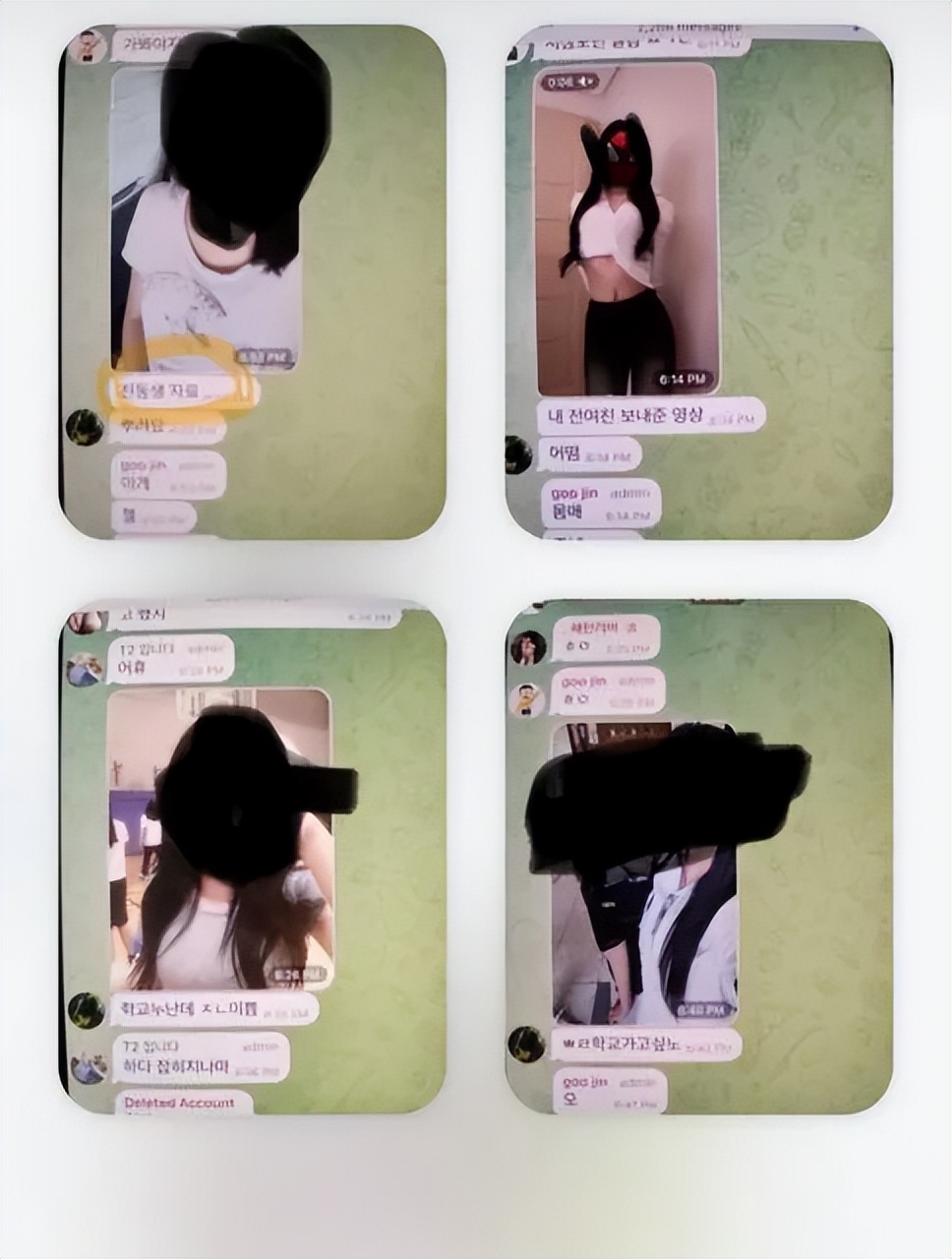

发帖人表示,“几乎所有地区的韩国学校都与Deep Fake事件有关”。并且最近一个与Deep fake相关的Telegram聊天室成员竟高达22.7 万,AI换脸能在5 秒钟内生成裸体合成图,供这群韩男罪犯泄欲和传播。

如果发声属实,无法想象多少身处韩国的女性正被网络“视奸”。

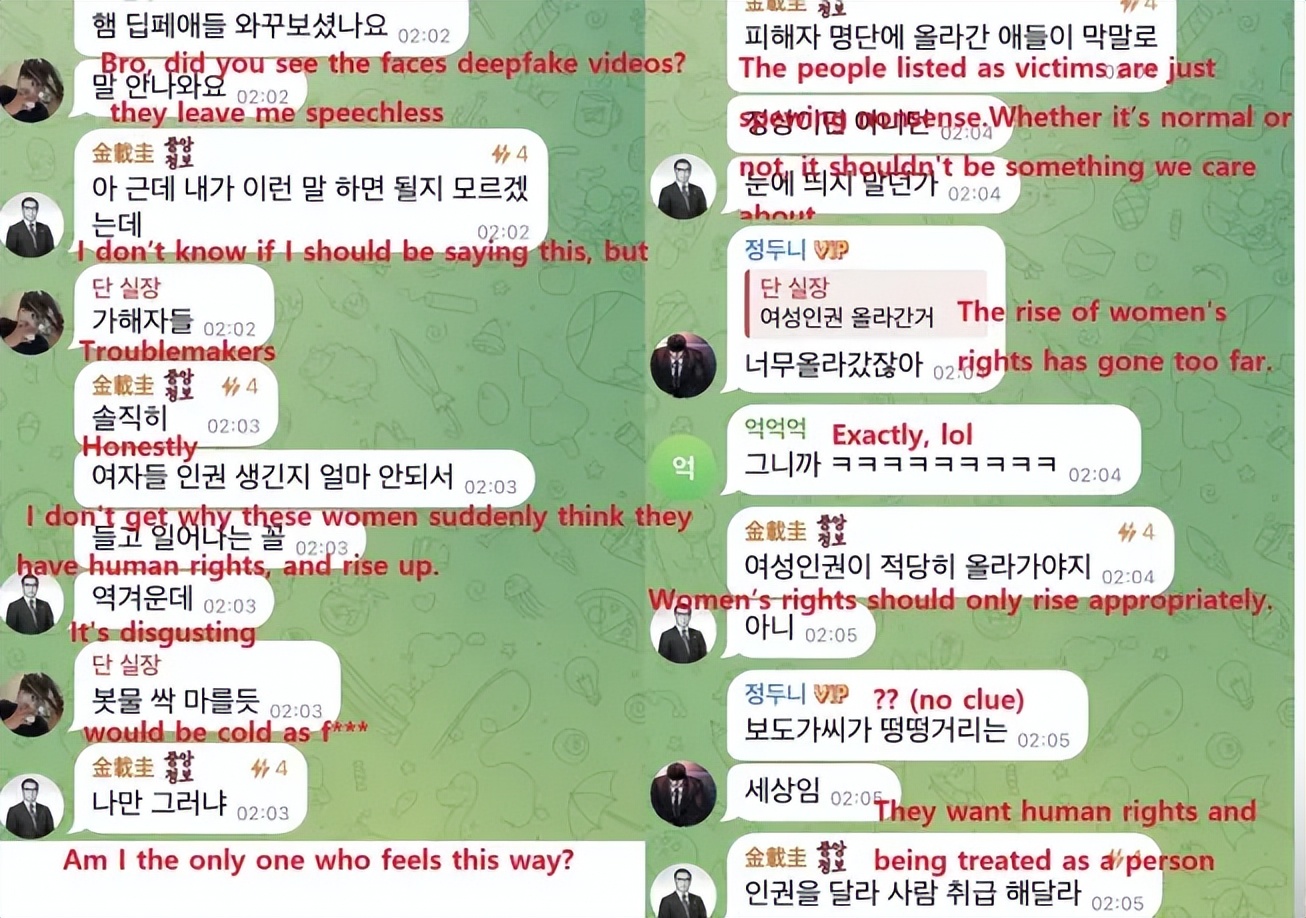

而和当初“N号房”的准入门槛一样—— 要想进入这些聊天室,必须提交一组自己周围女性的照片和详细个人信息,比如同学、姐妹或朋友...

这其中,无论受害者还是加害者,都有大量未成年人!

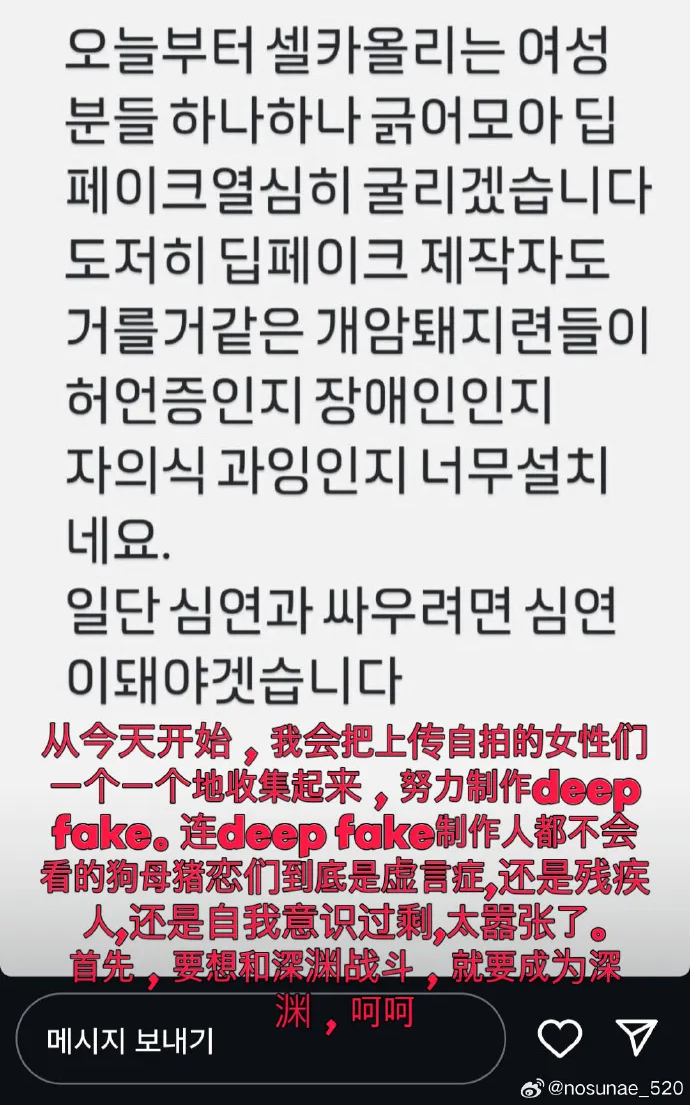

并且这群韩男罪犯非常猖獗,有舆论苗头的时候,他们会稍微“克制”一下:

面对反抗声浪,他们辱骂女性,并且威胁道:

“我会将上传自拍的女性一个个收集起来”

“你们太丑了,根本不会被(盗图)用在那些东西上”

“不要把我们当成潜在的犯罪者,女权主义者们”

“别夸张了,你们被骗了吗”……

各种发言不堪入目。

当韩女们无奈将自己上传到社交媒体的照片删掉时,韩男也会冲上来冷嘲热讽,甚至有初中男生开公开写到“不用担心,你不够漂亮,不至于被Deepfake”这种极端厌女的言语。

而其中一些房间,甚至是一些男牲通过拍摄对自己亲妹妹或亲生母亲上下其手的照片或视频、以“羞辱”家人为主题的。

一个名为@Queenarchive1的账户,是最早曝光此事的几个账户之一。在聊天室截图中,一名男性肇事者发布了一段视频,他在妹妹睡觉时掀起她的裙子,并进行了越界触摸。

他们就这样把自己前女友、亲妹妹、母亲的视频和照片,发到聊天室里,让房间里的其他犯罪者评鉴、泄欲和制作色情视频...

值得注意的是,这项号称只需要几秒钟、就能将照片中人物的衣服脱掉的“世界最先进技术”,现在只能处理女性形象,即使上传男性的脸部照片,也只会合成于女性的身体上,堪称专门针对女性群体的围剿。

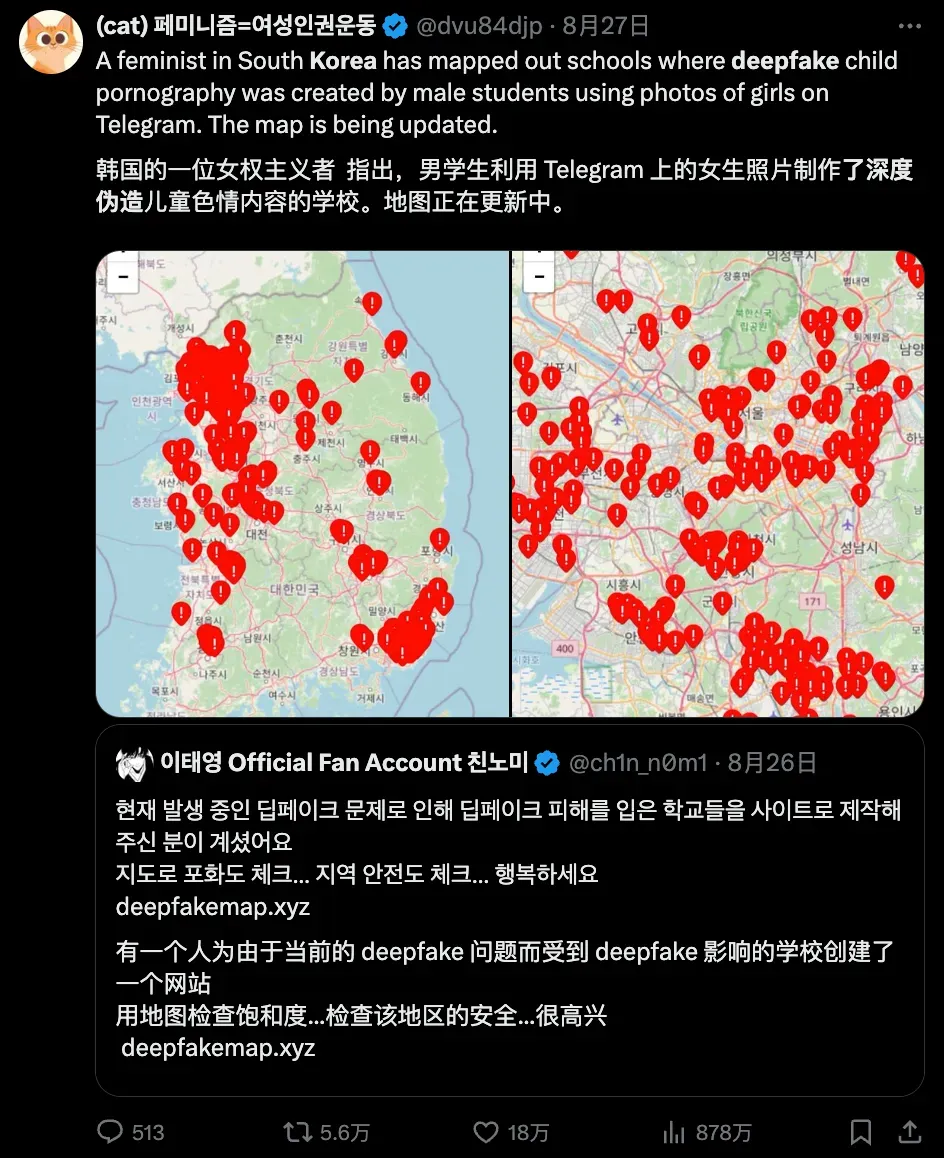

在X上,有韩国志愿者根据网络信息梳理总结,制作出了一套“受到Deepfake影响的学校”列表,显示韩国已有超过 500所小学、中学及大学受到威胁。

仅仅一个聊天室就有22.7万成员,这个数据是什么概念呢?去年韩国新生儿的数量也只有23万。所以不难想象,这件事情的曝光,已经引起全韩国范围内女性的极大恐慌和愤慨...

但韩女将“阵地”转向如中国微博、X等韩国之外的社交媒体,实则暴露了本次大规模AI性暴力的更深层次原因——目前韩国警方于8月27日宣布,将开展为期 7 个月的打击深伪性犯罪专项行动。

关注舆社!

了解更多新鲜事儿~