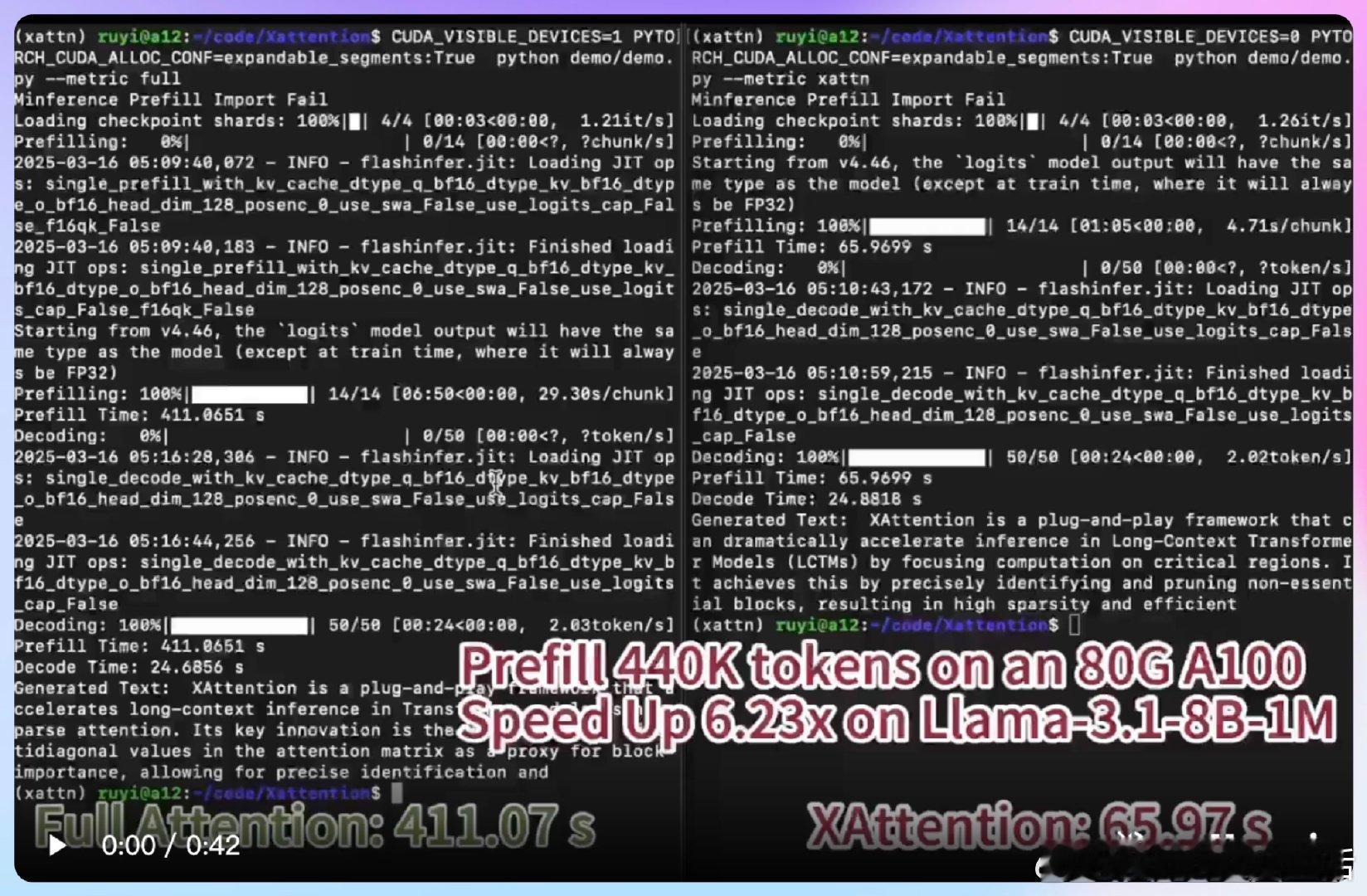

【[84星]XAttention:一种高效的Transformer注意力机制,让长文本处理速度提升13.5倍!亮点:1. 基于对角线和的轻量级指标,精准识别重要注意力块;2. 在长文本、视频生成和理解等多个场景表现出色;3. 无需牺牲精度即可实现加速】

'XAttention: Block Sparse Attention with Antidiagonal Scoring'

GitHub: github.com/mit-han-lab/x-attention

Transformer 长文本处理 视频生成 AI创造营