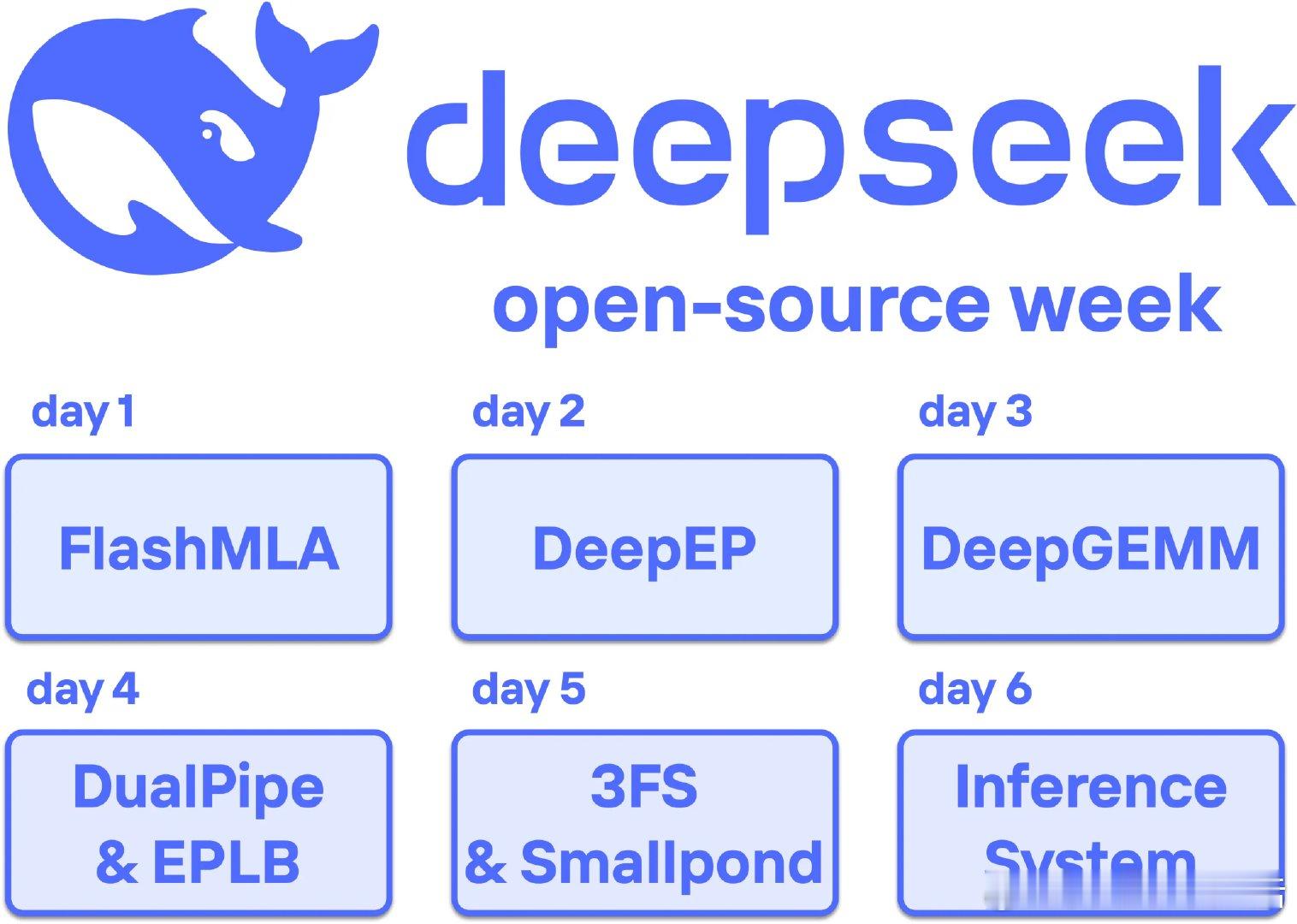

【DeepSeek开源周总结】

DeepSeek 在其 “开源一周” 活动中,发布了六个软件库,这些库分别针对不同的问题:

Day 1: FlashMLA - 提供了一个高效的 CUDA 核心实现,用于多头潜在注意力(MLA),特别是针对 Hopper GPU 的变长序列处理。它实现了高达 3 TB/s 的内存带宽利用率,显著提高了注意力机制的性能。

Day 2: DeepEP - 这是一个专门针对混合专家(MoE)模型的通信库,优化了 “分派” 和 “合并” 操作,提高了跨多个 GPU 和节点的数据路由效率。

Day 3: DeepGEMM - 一个专门为 Hopper GPU 设计的 FP8 矩阵乘法库,提供了对小型、不规则矩阵和大型计算密集型矩阵的优化,以及对混合专家模型的支持。

Day 4: DualPipe 和 EPLB - 提出了一种双向流水线并行算法和专家并行负载均衡器,用于提高多 GPU 环境下的计算效率和负载均衡。

Day 5: 3FS 和 Smallpond - 这两个工具分别是一个高性能的分布式文件系统和一个基于 DuckDB 的分布式数据处理框架,用于解决大规模语言模型训练和推理中的数据基础设施挑战。

Day 6: DeepSeek-V3/R1 - 介绍了 DeepSeek-V3/R1 的推理系统架构,展示了如何在大规模跨节点专家并行中实现高效的推理服务,并且在成本和性能之间取得了平衡。

'DeepSeek's open-source week and why it's a big deal'

网页链接:

AI开发 开源项目 AI框架 AI创造营