通义春节开源多个模型 通义在春节期间的开源动作,让人眼前一亮。

1月27日凌晨,通义宣布开源支持100万Tokens上下文的Qwen2.5-1M模型,推出7B及14B两个尺寸,在处理长文本任务中稳定超越GPT-4o-mini。开源了推理框架,在处理百万级别长文本输入时可实现近7倍的提速。

1月28日凌晨,通义又宣布开源全新的视觉理解模型Qwen2.5-VL,能够在视觉理解领域超越GPT-4o和Claude3.5,拿下十余项权威评测中的视觉理解冠军。

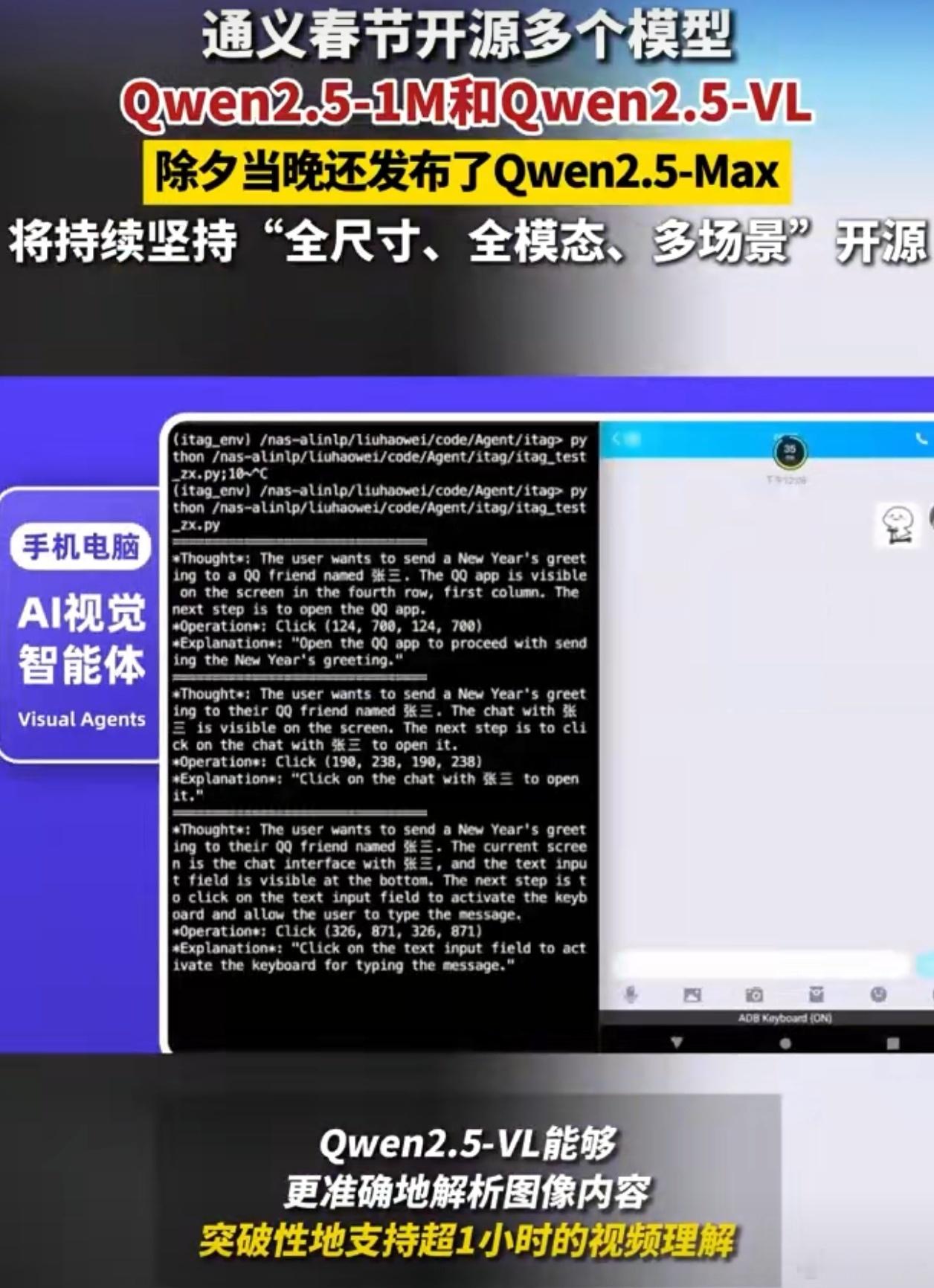

新的Qwen2.5-VL能够更准确地解析图像内容,突破性地支持超1小时的视频理解,无需微调就可变身为一个能操控手机和电脑的AI视觉智能体。

想象一下,一个AI模型不仅能看懂图片,还能理解超长视频,甚至直接操控手机和电脑帮你完成订票、修图、送祝福这些复杂操作,这不妥妥的“生产力工具”吗[喵喵]

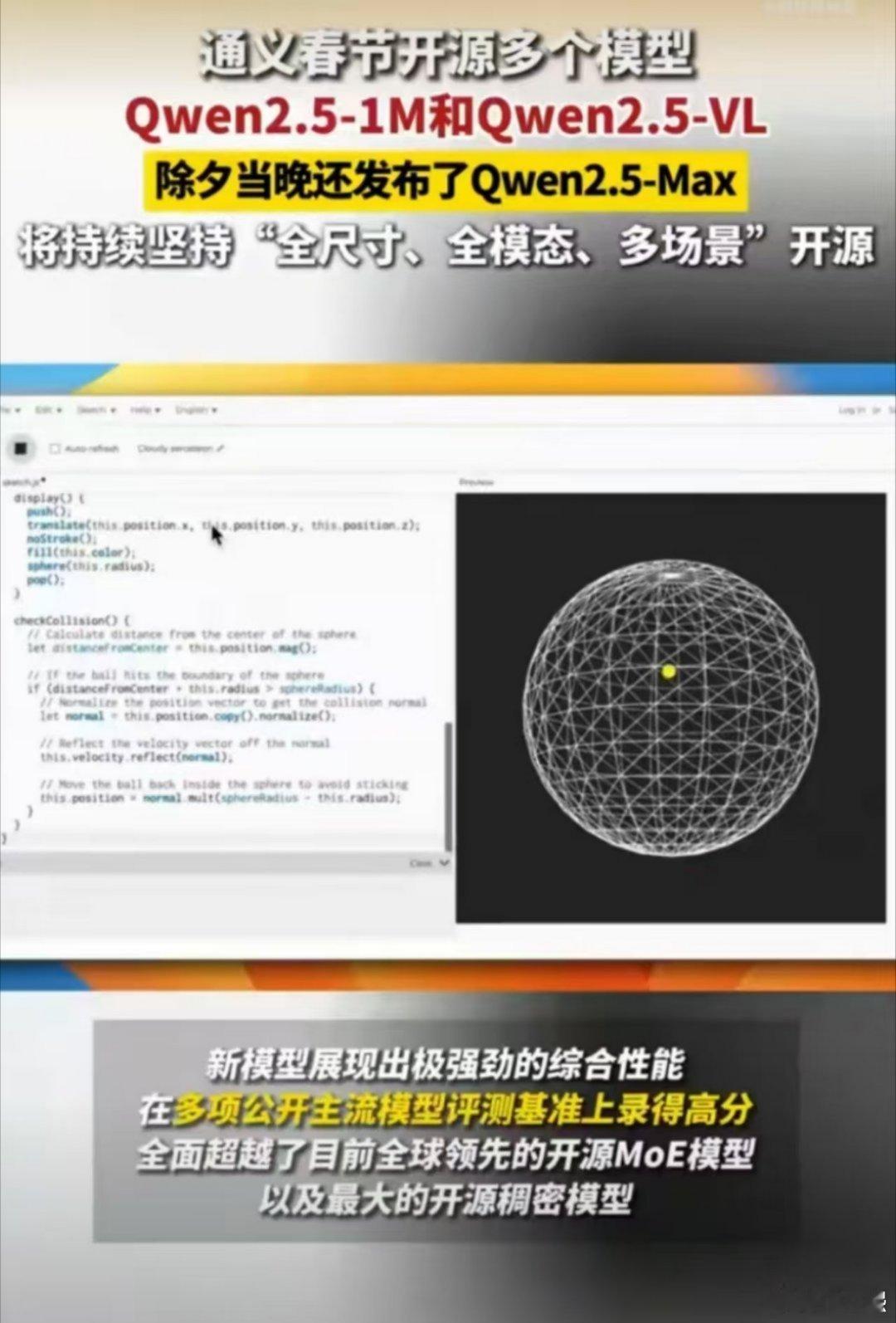

1月29日,Qwen2.5-Max全新升级发布,是通义团队对MoE模型的最新探索成果,在多项公开主流模型评测基准上录得高分,全面超越了目前全球领先的开源MoE模型以及最大的开源稠密模型。

通义的开源策略,让我觉得最赞的地方是它的“普惠性”,它没有把技术锁在自家院子里,而是选择开放给全球开发者。

这种开放的态度,不仅让中国AI生态受益,也让海外开发者们纷纷“真香”,VL系列总下载量突破3200万,成为最受欢迎的视觉理解多模态模型。其实这个数字本身就说明了很多问题——技术无国界,好的工具大家都愿意用。