有人问什么是VLM视觉语言模型[笑cry]

通俗地说,这是一个擅长解读照片的网络。

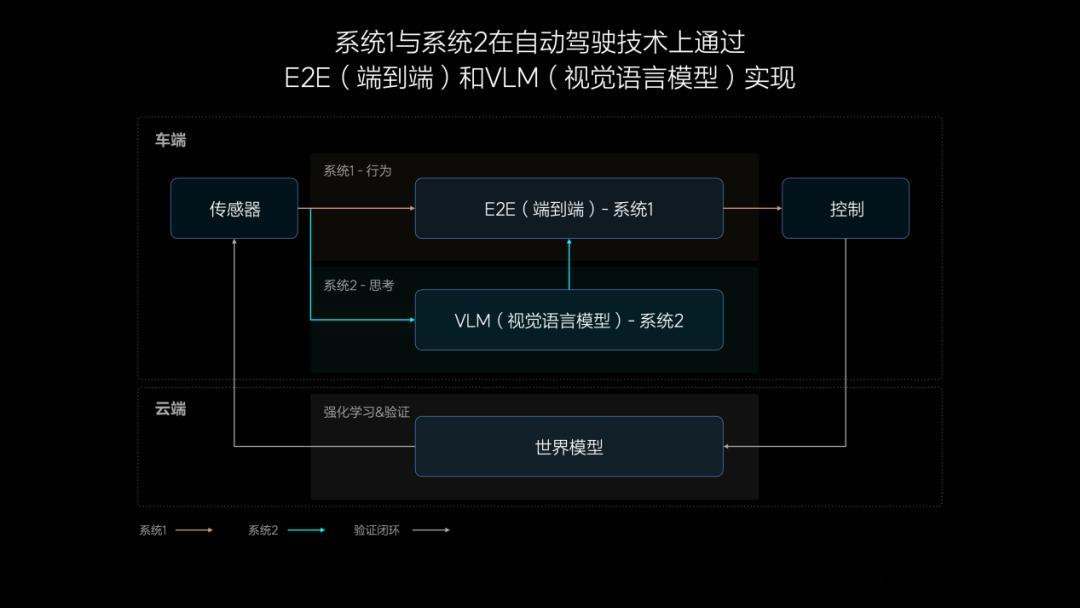

我们都知道,自动驾驶感知主要输入的是图片,这是最重要的信息,但如何让系统读懂信息,这是最关键的一步。

VLM 模型相对来说更擅长这些场景理解,能识别和描述道路环境、交通标志、动态交通参与者等等。通过不断的训练,VLM能够进行自主推演。例如交警的手势,大多数模型架构是无法解决「读懂」的,甚至人的大脑都需要推理,但是VLM可以承担这部分任务。

这就是为什么李想说,VLM是端到端很好的补充。

理想汽车的VLM视觉语言模型参数量达到22亿,对物理世界的复杂交通环境具有强大的理解能力,许多场景即便是第一次经历,也能够很好地化解。

再举个例子,VLM模型可以理解公交车道、潮汐车道和分时段限行等复杂的交通规则,在驾驶中作出合理决策。

可以说,VLM给端到端在给端到端这种不可加规则的模型进行了很好的兜底。

但是,VLM本身也是黑盒,理想为了验证双系统的安全性,用 Diffusion Transformer 的方式来构建一个重要的、小型的世界模型,拿到这个世界模型,让车在里面考试。

理想汽车结合端到端模型和VLM视觉语言模型,成为了首个在车端部署双系统的方案,也首次将VLM视觉语言模型成功部署在车端芯片(Orin-X)上。

#理想智能驾驶夏季发布会# #AutoLab# #汽场全开#